Ontkracht: 10 SEO-mythes anno 2014

SEO-misverstanden & waarom dat zo is

Ja, dat lees je goed. 2014. En nee, ik ben niet helderziend. In januari presenteerde ik bij Bol.com (slides) al eens over diverse SEO-mythes en ik merk dat ze allemaal nog steeds de ronde doen. Ik durf het dus zeker aan om te stellen dat onderstaande SEO-mythes in 2014 nog steeds rondgaan. En ik zal uitleggen waarom het mythes zijn: gangbare, maar ongegronde opvattingen.

In het vakgebied van zoekmachine-optimalisatie (SEO) doen veel mythes de ronde. Dat is op zich ook logisch, omdat we nu eenmaal te maken hebben met een ‘black box’: het algoritme van zoekmachine Google (en andere zoekmachines). Maar in mijn dagelijkse praktijk als adviseur merk ik al jaren dat deze mythes leiden tot misverstanden, verkeerde keuzes of zelfs negatieve SEO-resultaten.

Hieronder 10 SEO-mythes – in willekeurige volgorde – die ik nog steeds regelmatig hoor terugkomen. Sommige al meerdere jaren, sommige recenter. En natuurlijk waarom de mythes ongegrond verklaard kunnen worden.

1. Google vindt m’n pagina’s wel, ik hoef niks te doen

De definitie

Google is steeds beter geworden in het vinden van (nieuwe) websites en webpagina’s, hoofdzakelijk met de zoekmachinerobots.

De mythe

Met de explosieve groei van de hoeveelheid informatie op het web, zorgt Google natuurlijk ook voor meer capaciteit (rekenkracht, opslagruimte, crawl-capaciteit, etc.). Met deze sterk toegenomen en groeiende capaciteit van Google zou je kunnen denken dat Google jouw nieuwe of aangepaste website of webpagina eenvoudig vindt.

Maar dat is lang niet altijd het geval.

De mythe ontkracht

Een voorbeeld uit de praktijk: voor een opdrachtgever stond een website al geruime tijd live (langer dan een jaar). Google had veel pagina’s gevonden en geïndexeerd, maar er waren nog steeds veel pagina’s niet geïndexeerd (ondanks dat Google de pagina’s in theorie wel kon vinden via interne links).

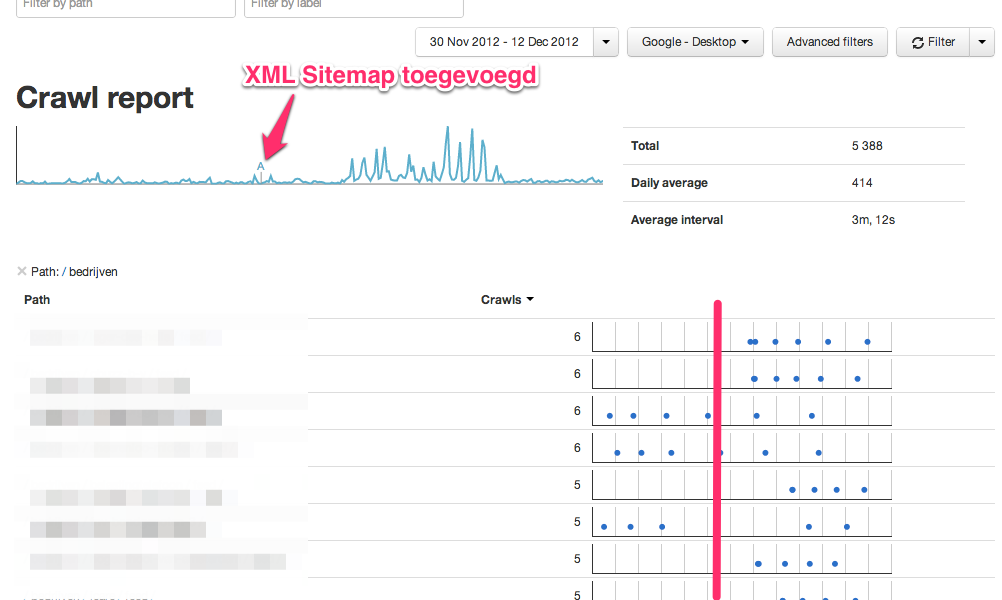

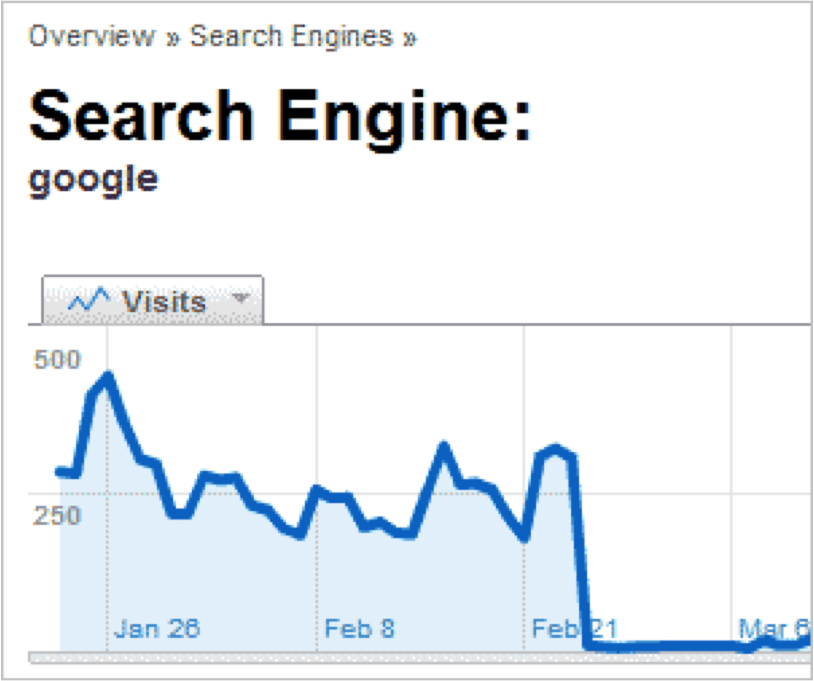

We onderzochten het gedrag van de Googlebot om eerst vast te stellen of de betreffende pagina’s überhaupt gecrawld werden. Dat bleek niet het geval. Pas na het toevoegen van een XML-sitemap zagen we dat de pagina’s keurig gecrawld en geïndexeerd werden.

Afbeelding 1: crawling Googlebot na toevoegen XML sitemap (bron: interne tool OrangeValley)

Elk puntje in afbeelding 1 is een crawl van Googlebot. Het is duidelijk te zien dat na implementatie van de XML-sitemap een aantal pagina’s gecrawld werden. Dat leidde binnen korte tijd tot een verdubbeling(!) van bezoekers uit SEO.

2. Hoe hoger m’n PageRank, hoe hoger m’n ranking

De definitie

Google geeft elke pagina/url op internet een ‘rapportcijfer’ op een schaal van 1 tot 10, Google PageRank genaamd. De PageRank-score is overigens al sinds februari 2013 niet meer is geactualiseerd en het voortbestaan (in de buitenwereld) lijkt op losse schroeven te staan – maar Google gebruikt het intern nog dagelijks in het algoritme.

De mythe

Ik hoor nog regelmatig mensen beweren dat een hoge PageRank zorgt voor hoge rankings in de zoekresultaten. En dat links van websites alleen wat waard zijn als de pagina/site PageRank heeft. Dat is absoluut een mythe.

De mythe ontkracht

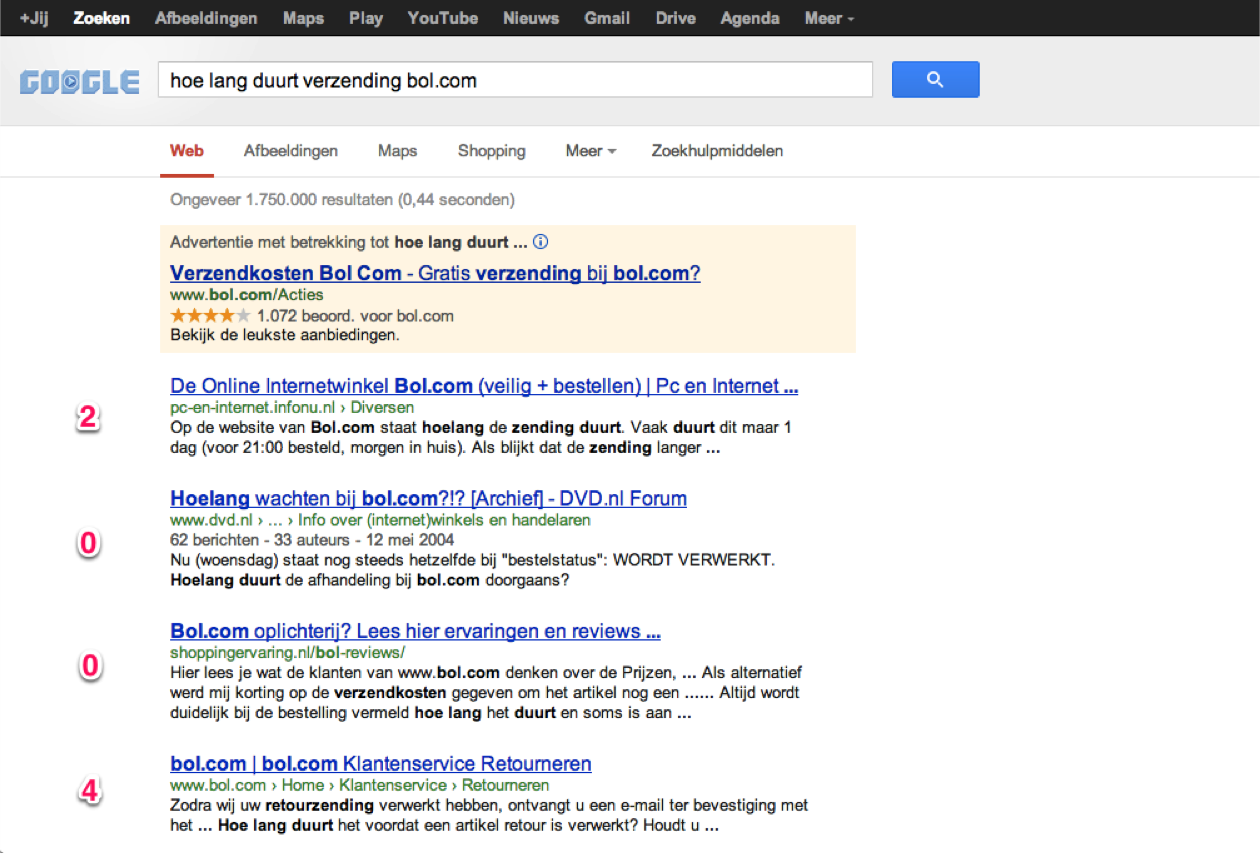

Je kunt zelf eenvoudig controleren of de webpagina’s met de hoogste PageRank ook de hoogste posities in de zoekresultaten innemen.

Kijk eens naar dit voorbeeld:

Afbeelding 2: voorbeeld van PageRank score per zoekresultaat (Google.nl, januari 2013)

Het is duidelijk te zien dat pagina’s met een hoge PageRank absoluut niet altijd hoog scoren.

3. Exact match-domeinen werken niet meer

De definitie

Wanneer een domeinnaam exact overeenkomt met een zoekopdracht, wordt dit een ‘exact match domain’ (EMD) genoemd. Bijvoorbeeld voor de zoekterm ‘vliegtickets new york’ is www.vliegticketsnewyork.nl een exact match-domein.

De mythe

In september kondigde Google (via Twitter) aan dat exact match-domeinen van lage kwaliteit lager zouden gaan scoren in de zoekresultaten, ook wel bekend als de ‘EMD-update’ (zie ook dit Marketingfacts-artikel).

De mythe ontkracht

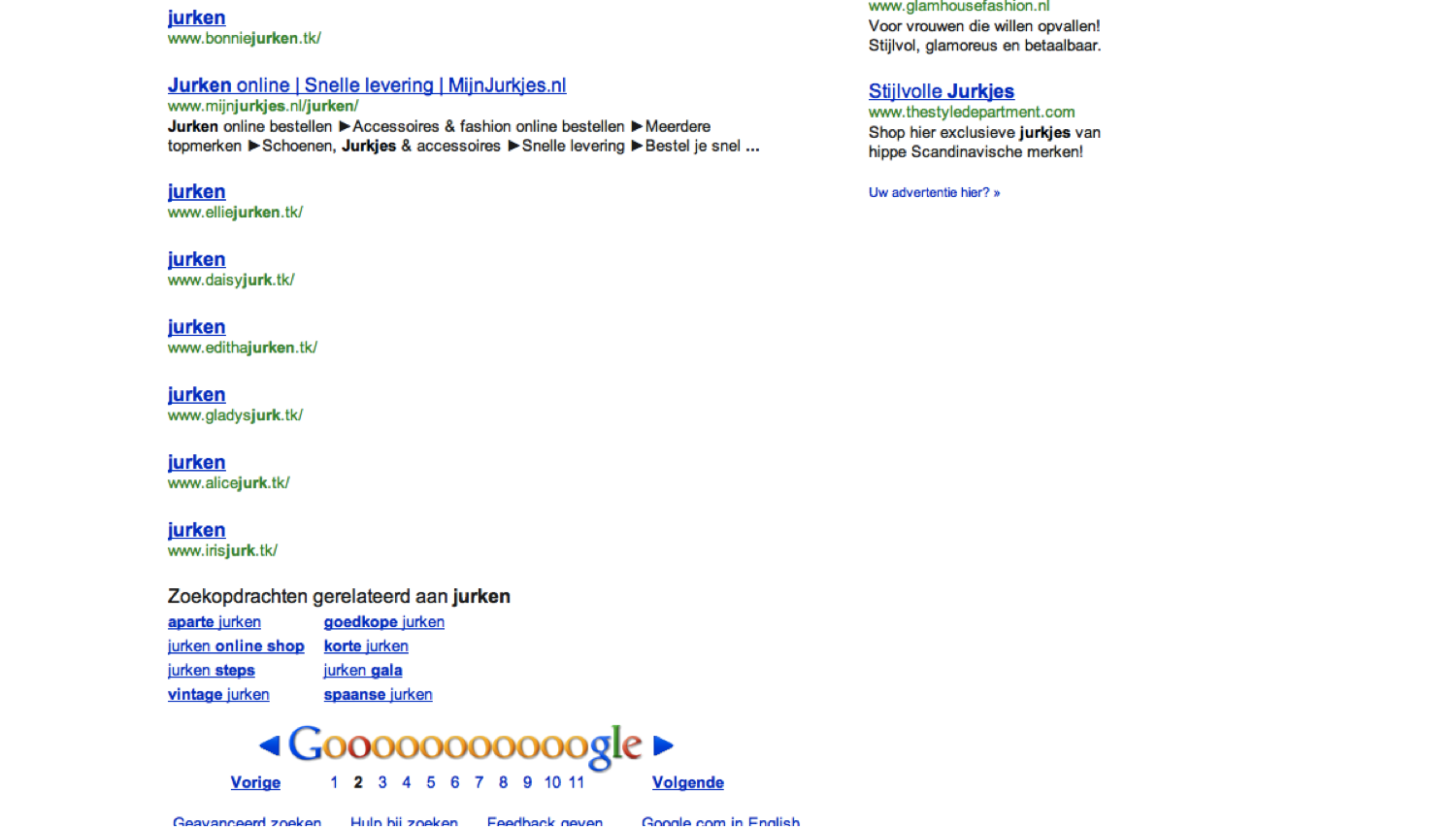

Door zelf een aantal zoekopdrachten uit te voeren, weet je snel genoeg of (lage kwaliteit) exact match-domeinen nog steeds scoren. Sterk gerelateerd aan exact match-domeinen zijn ‘partial match‘-domeinen (PMD): de domeinnaam bevat een gedeelte van de focus-zoekterm.

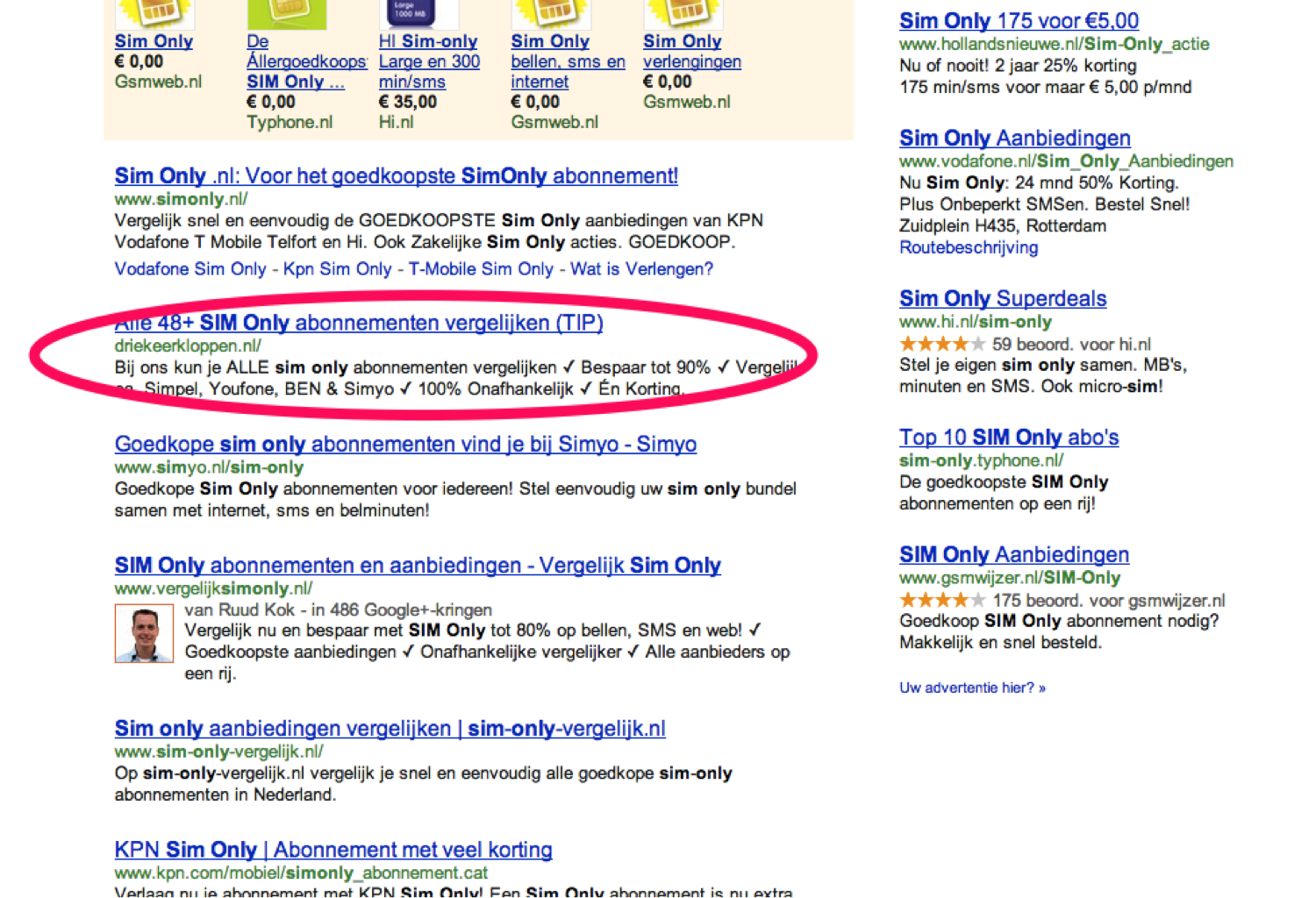

Een paar voorbeelden van dit soort domeinen, waarbij met name partial match-domeinen veel terug te vinden zijn op een competitieve zoekterm:

Afbeelding 3: voorbeeld van een paar (te) goed scorende exact & partial match domeinen (Google.nl, november 2013)

Ik zie de zoekresultaten langzaam en met kleine stapjes wel verbeteren, maar zoals je ziet is Google’s belofte nog lang niet waargemaakt. In ieder geval niet in Nederland (dat voor Google simpelweg ook een minder belangrijk taalgebied is). Natuurlijk zijn zeker niet al deze sites van lage kwaliteit, maar ik zie dagelijks veel voorbeelden van EMD’s en PMD’s die echt van zeer lage kwaliteit zijn.

4. Duplicate content wordt afgestraft

De definitie

Wanneer dezelfde, of identieke content, te vinden is op meerdere locaties (URL’s), dan is er sprake van ‘duplicate content’. Dat geldt zowel binnen een website als tussen meerdere websites. Google en andere zoekmachines streven ernaar nooit dezelfde content meerdere keren terug laten komen in de zoekresultaten. Google geeft zelf aan:

“…Google streeft ernaar pagina’s met verschillende gegevens te indexeren en weer te geven.…”

De mythe

Veel mensen denken dan ook dat duplicate content een straf of ‘penalty’ oplevert van Google. Dat wil zeggen dat jouw website op een lagere positie in de zoekresultaten wordt geplaatst.

De mythe ontkracht

Allereerst levert duplicate content nooit een penalty op (zie de volgende mythe). Alle andere wijzigingen in de positie van jouw website in de zoekresultaten gaan automatisch via een algoritme. Dat geldt dus ook voor duplicate content. Ten tweede wordt dezelfde, en met name identieke, content op meerdere url’s lang niet altijd uit de zoekresultaten gefilterd.

Kijk hier maar eens naar:

Afbeelding 4: duplicate content in de zoekresultaten (Google.nl, 2012)

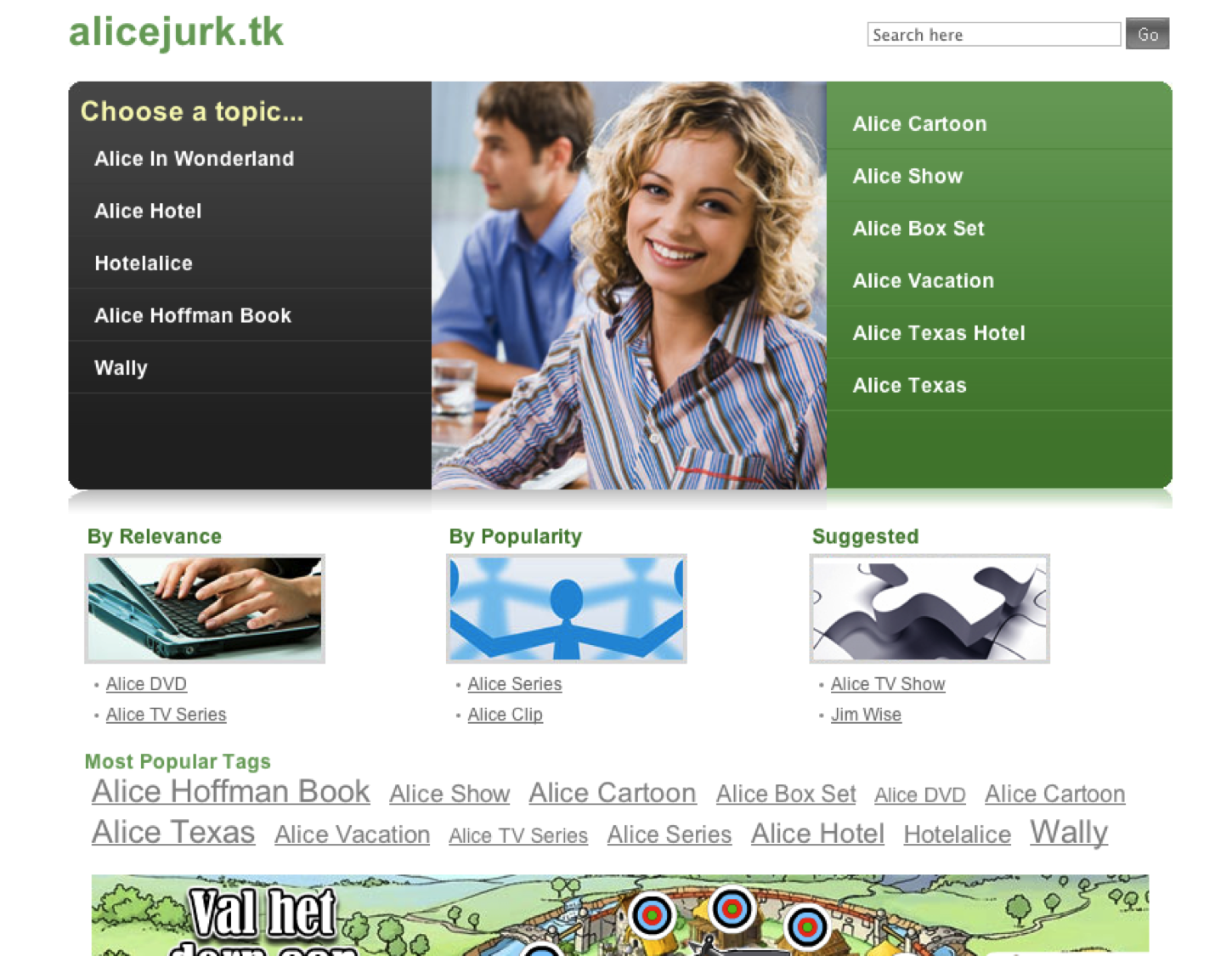

En kijk vervolgens eens naar deze websites:

Afbeelding 5a: website 1

Afbeelding 5b: website 2

Zoek de verschillen 😉

Natuurlijk is dit een extreem voorbeeld. En, om eerlijk te zijn, dit voorbeeld stamt uit 2012. Maar het geeft wel mooi aan dat duplicate content lang niet altijd uit de zoekresultaten gefilterd wordt.

Het is eigenlijk altijd nodig om iets aan duplicate content te doen. Dat zal je vindbaarheid alleen maar verbeteren. Maar je hoeft nooit bang te zijn voor een straf of ‘penalty’ wanneer er wel sprake is van duplicate content.

5. Help, m’n site heeft een Google penalty!

De definitie

Google neemt soms handmatige acties – een penalty – tegen websites die technieken gebruiken tegen de richtlijnen (spam). Dit kan een verlaging of in het meeste extreme geval een verwijdering uit de zoekresultaten zijn.

Een recent voorbeeld begin deze maand van een zeldzame penalty in Nederland is hier op Marketingfacts ook behandeld: “Nederlandse merken ‘beboet’ door Google voor twijfelachtige SEO-praktijken”.

De mythe

Stel je voor: je ziet de volgende grafiek in je webstatistieken:

Afbeelding 6: voorbeeld terugval aantal bezoekers uit Google

Auch.

Dan schrik je natuurlijk. Heel vaak hoor ik mensen dan roepen: “ik heb een penalty van Google!”. Meestal is dat echter niet het geval. Een penalty is namelijk altijd een handmatige actie van Google en dat wordt heel weinig toegepast.

De mythe ontkracht

Tot nu toe was het vaak lastig om te achterhalen of je een penalty had of niet. Al was het in een paar gevallen eenvoudig de afgelopen 2 jaar, namelijk met de Google Panda-algoritme-updates en Google Penguin-algoritme-updates. Hiervan zijn de updatedatums namelijk bekendgemaakt door Google (al zijn ze daar met het Panda-algoritme mee gestopt en ik verwacht dat dit met het Penguin-algoritme ook zal gebeuren).

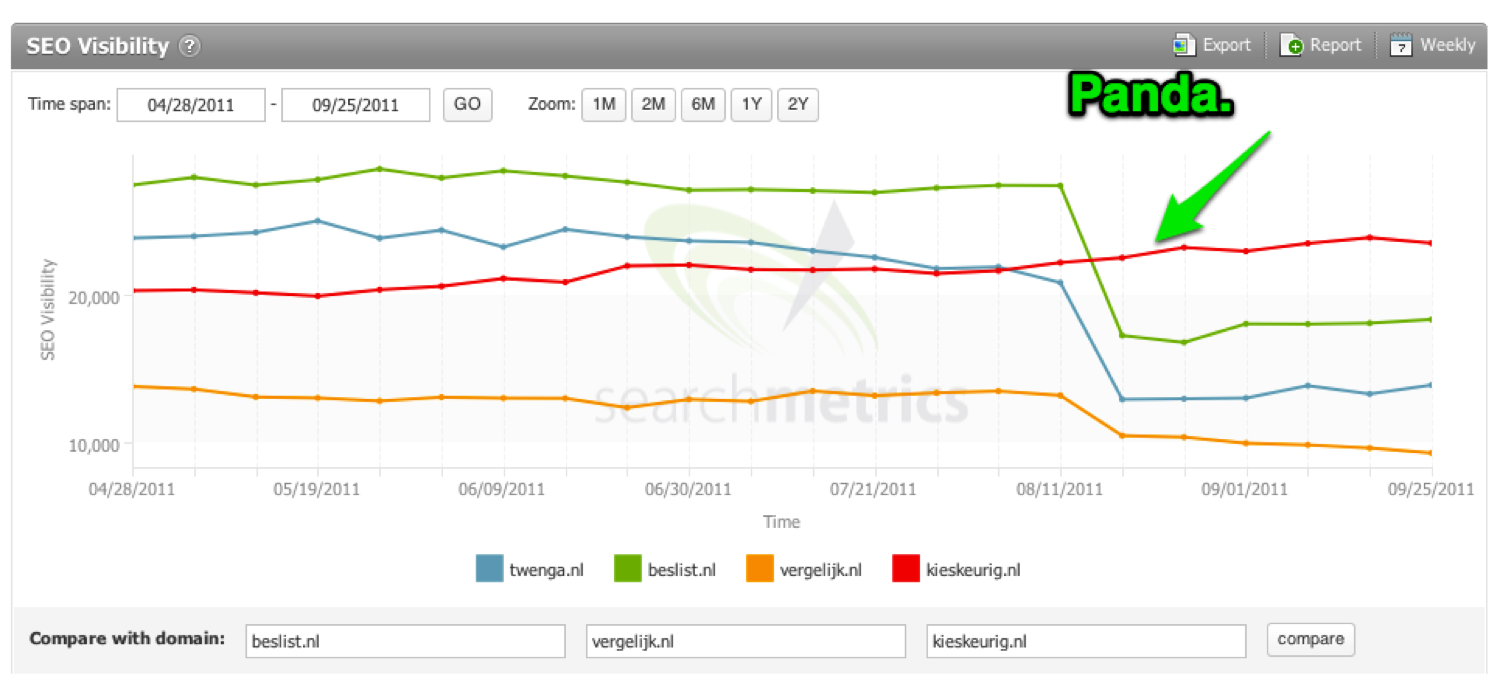

Een voorbeeld hiervan:

Afbeelding 7: voorbeeld van websites die “geraakt” zijn door de Google Panda update (Searchmetrics, oktober 2011)

Hier is duidelijk te zien dat een aantal sites fors terug is gevallen in hun organische vindbaarheid na de wereldwijde uitrol van het Google Panda-algoritme in augustus 2011. In dit geval is er dus geen sprake van een penalty, maar gewoon een automatische algoritmeverandering.

Hoe weet je of je een penalty hebt? Dat is tegenwoordig heel eenvoudig: Google vertelt het je. Sinds augustus 2013 vindt je dat terug in Google Webmaster Tools. Meestal zal je hier dus niets zien, ook al zie je een teruggang in je SEO-resultaten. En dan zul je gewoon hard moeten werken en je houden aan de Google-richtlijnen.

6. Footer links werken niet meer

De definitie

Footer-links zijn een lijstje links die onderaan elke pagina van een website staan. Dit aparte blok onderaan elke pagina wordt footer genoemd.

De mythe

Er zijn diverse mensen die beweren (voorbeeld) dat footer-links niet meer werken voor SEO. Met name ook naar aanleiding van uitspraken van Google, zoals: “We’ve done a good job of ignoring boilerplate, site wide links”. Ook de ‘page layout’-algoritme-update toont aan dat Google herkent op welke positie content en links op een pagina staan (voor bezoekers!).

De mythe ontkracht

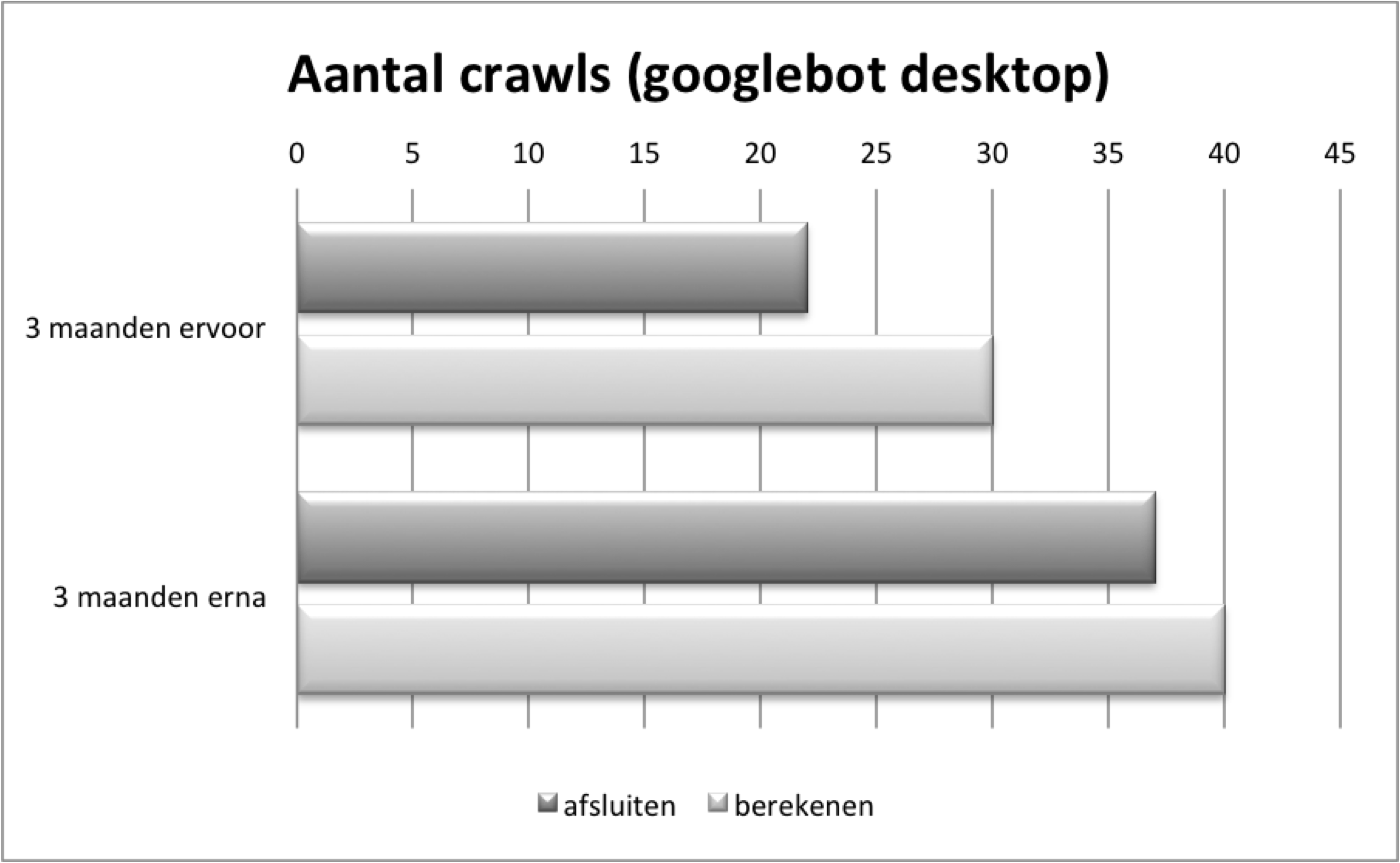

In de praktijk zie ik echter dat footer-links nog steeds een waarde kunnen hebben. Kijk bijvoorbeeld eens naar de volgende cijfers van het aantal (Googlebot-)crawls:

Afbeelding 8: aantal Googlebot-crawls na het toevoegen van footer-links (bron: interne tool OrangeValley)

Nu denk je natuurlijk: “Ja, Eduard, dat is logisch. Je hebt meer links toegevoegd, dus worden er ook meer crawls geregistreerd.” Dat klopt. Maar dan moet je ook weten dat de pagina’s waarnaar gelinkt is, gestegen zijn van buiten de top-10 naar top-3-posities.

Belangrijk om te weten, is dat de footer-links alleen toegevoegd zijn op relevante pagina’s. Dus het betreft hier geen footer-links die op elke pagina van de hele site staan.

7. Keyword-linkteksten worden afgestraft

De definitie

De ‘anchor text’ of linktekst is de tekst waarmee naar een andere pagina gelinkt wordt. Een ‘keyword-linktekst’ bevat hoofdzakelijk woorden die overeenkomen met een belangrijk SEO-keyword.

De mythe

Nadat Google sinds 2012 regelmatig een Penguin-algoritme-update doorvoert en na de gewijzigde ‘linkbuilding’-richtlijnen afgelopen zomer, heerst er in SEO-land de opvatting dat linkteksten met keywords niet meer werken en worden afgestraft.

De mythe ontkracht

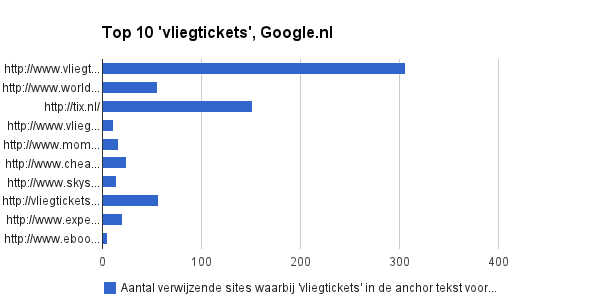

Je kunt zelf eenvoudig de zoekresultaten op aantal keywords analyseren met behulp van een linkanalysetool (zoals Open Site Explorer of Majestic SEO). Dan zie je bijvoorbeeld de volgende grafieken terug:

Afbeelding 9: voorbeeld van websites die goed scoren waarvan belangrijke keywords in linkteksten voorkomen (november 2013)

Er zijn natuurlijk veel factoren die de ranking bepalen, dus het is absoluut te kort door de bocht om te concluderen dat dit door keywords in linkteksten komt. Maar het mag ook geen toeval genoemd worden dat de hoog scorende sites ook hoog scoren in aantallen links waarvan de anchor-tekst het belangrijkste keyword bevat.

8. Cloaking werkt niet meer

De definitie

Wanneer je een zoekmachine iets anders toont dan een bezoeker, dan heet dat “cloaking”. Dat is al jaren tegen de richtlijnen van Google en andere zoekmachines.

De mythe

Cloaking is een oude spamtechniek die al jaren wordt toegepast. Met de jaren is Google steeds beter geworden in het automatisch herkennen en eruit filteren van dit soort spamtechnieken. Er heerst dan ook de opvatting dat cloaking geen zin meer heeft en niet meer werkt. Google geeft zelf ook aan: “Cloaking is High Risk”.

De mythe ontkracht

Allereerst moet ik zeggen dat Google ook echt beter is geworden in het automatisch herkennen van cloaking. Maar ik zie nog steeds dat er af en toe cloaking tussen de zoekalgoritmes doorglipt.

Een voorbeeld uit begin 2013:

Afbeelding 10: voorbeeld van een website die er op het eerste gezicht normaal uitziet

Maar als je verder kijkt, dan zag je dat er geoptimaliseerd tekst verborgen was:

Afbeelding 11: maar, wanneer je verder kijkt, is er SEO geoptimaliseerde tekst verborgen

Daarbij werd er nog een tweede truc gebruikt, waarbij een eerder gebruikt domein werd ingezet om deze site te boosten. En het (eerder gebruikte domein) scoorde binnen de korte keren hoog in Google.nl:

Afbeelding 12: voorbeeld van cloaking die hoog scoorde in Google.nl

Je moet weten dat dit er misschien 2 dagen zo heeft gestaan. Het werd namelijk snel opgemerkt, aangegeven bij Google en de site kreeg een penalty. De cloaking was dus kort effectief, maar het gaat mij erom dat dit soort dingen er anno 2013 nog steeds tussendoor glippen en zeker (nog) niet altijd automatisch herkend en verwijderd worden. Ook internationaal zijn daar recente voorbeelden van.

Op dit moment gebruikt de site uit bovenstaand voorbeeld overigens niet meer de cloaking-techniek.

9. Social media zijn noodzakelijk voor toppositie

De definitie

Social media zijn alle platformen waar mensen met elkaar communiceren, waarvan social networks een grote en belangrijke groep zijn.

De mythe

Op bijna elk blog dat over SEO schrijft, is wel terug te lezen dat social media belangrijk zijn en belangrijker worden voor je organische vindbaarheid. Ook diverse recente onderzoeken geven een correlatie aan tussen socialmediaplatformen en hoge rankings.

De mythe ontkracht

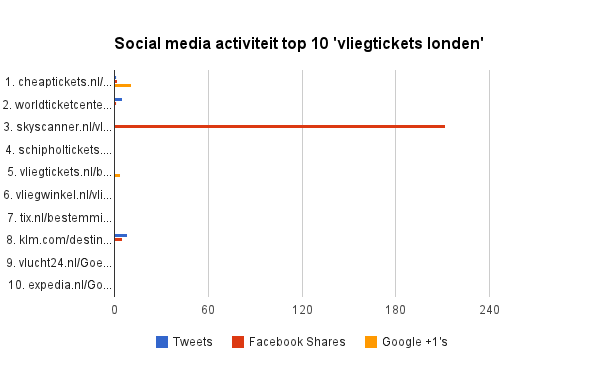

Allereerst kun je zelf eenvoudig naar diverse zoekresultaten kijken en analyseren of er veel socialmedia-activiteit is geweest voor de pagina’s die hoog scoren. Ook al analyseer je dan de correlatie (en niet causatie), dan kun je toch snel zien dat er veel pagina’s hoog scoren zonder actief te zijn op social media.

Kijk bijvoorbeeld eens naar dit voorbeeld:

Afbeelding 13: voorbeeld van pagina’s die hoog scoren zonder socialmedia-activiteit

Natuurlijk worden social media steeds belangrijker in de zoekalgoritmes. Maar absoluut gezien weegt het op dit moment lang niet zo sterk mee als vele andere factoren.

10. Infographics zijn waardeloos voor linkbuilding

De definitie

Infographics zijn visuele (re)presentaties van data. De laatste paar jaar is dit medium veel gebruikt met het doel er links mee te realiseren.

De mythe

In juli 2012 gaf Google aan dat links van infographics wellicht binnenkort niet meer mee zouden tellen voor je SEO-resultaten. In augustus van dit jaar sprak Google een advies uit om links van infographics nofollow te maken.

De mythe ontkracht

Ondanks dat er veel infographics van beroerde kwaliteit gemaakt worden, zijn er zeker voorbeelden te vinden van succesvolle infographics. Succesvol wil wat mij betreft primair zeggen dat de visualisatie functioneel is in het uitleggen van complexe of grote hoeveelheden informatie. Dat dit vervolgens links oplevert die je SEO helpen, moet wat mij betreft een bijeffect zijn.

Een mooi voorbeeld hiervan is de visualisatie van de schuld van de VS (en jawel, weer een link!). Kijk maar eens naar de cijfers:

Afbeelding 14: aantal links naar de infographic over de visualisatie van de schuld van de VS

Naast de zeer grote aantallen shares op social media levert dit ook een groot aantal links op.

11. …Jouw SEO-mythe…

Dit is natuurlijk niet bedoeld als een complete lijst met mythes. Ik kan er zo nog een aantal uit m’n dagelijkse praktijk opnoemen, zoals dat Google AdWords invloed heeft op SEO, dat het linken naar andere sites slecht voor je SEO is, etc. etc.

Welke SEO mythes kom jij regelmatig tegen, waarvan je denkt dat ze in 2014 nog de ronde doen? Ik verzamel bovenstaande en andere mythes op een centrale plek (m.b.v. Google Moderator). Voeg hier jouw SEO-mythes toe of stem op andere mythes!

Eduard, bedankt voor dit stukje. Ik heb er van genoten, al denk ik dat je wel wat commenttaar zult krijgen van mensen die wat anders “geloven”.

Ga zo door!

Vooral de mythe over duplicate content hoor ik nog vaak en ik moet toegeven hier ook in geloofd te hebben ;).

Waar ik mij echter helemaal over verbaasde, was een artikel in de Stentor een tijdje terug. In dit artikel werden 10 SEO-tips gegeven door één van de bekendste/grootste online marketing bureaus van Nederland. In één van de tips werd letterlijk geschreven dat duplicate content ervoor kan zorgen dat je website uit de index wordt verwijderd.

Voor een vooraanstaand bureau best wel een blunder…

Beste Eduard, met veel interesse je blog gelezen. Als communicatiespecialist, blogger en tekstschrijver ben ik vooral heel geinteresseerd in de waarheden en onwaarheden rondom content en google. Ik hoor bijvoorbeeld heel wisselende verhalen over het belang van invoeren van metateksten. Ik volg altijd de adviezen van wordpress-specialisten (tijd investeren in een goede, kernachtige en oprolbare tekst is vele malen waardevoller dan tijd besteden aan invoeren van metateksten…?). Ben benieuwd naar jouw visie hierop. Hartelijke groet vanaf Texel (vanaf daar run ik mijn communicatiebureau…:- )

Om even op je derde punt terug te komen: Ik heb nogal wat exact match domeinnamen. De groep waarop kleine (<10 pagina's) sites op stonden zijn helemaal weggezakt. Domeinen met veel pagina's (vrijwel allemaal feed-based) zijn nauwelijks gedaald.

Dat lijkt wel echt het criterium geweest te zijn. Op zich ook wel een valide benadering lijkt me.

Verder goede lijst, alleen je puntje van dat een penalty altijd handmatig is ben ik het niet mee eens. Zitten -tig penalty factors in die algoritmes, denk aan het sanbox-effect.

@Femmy, metateksten zijn in zoverre belangrijk dat je er een call-to-action in kan verwerken wat kan leiden tot een betere CTR. Voor zo ver ik weet worden deze teksten niet meegenomen in het algoritme van Google, dus je gaat er niet beter of slechter door ranken. Maar een goede call-to-action lijkt mij van toegevoegde waarde.

Ik ben het inderdaad met Ulco eens, bij een bepaalde update kan je wegzakken en ‘betrapt’ worden op spammy activiteiten waardoor het lastiger wordt te scoren met een bepaalde site. Ervaring zegt dat een nieuwe site op dezelfde zoekwoorden met gelijkwaardige teksten en ‘vernieuwde’ tactiek stukken beter rankt dan een ‘aangepaste’ techniek (waarschijnlijk) door een penalty.

Beste Eduard,

Interessant artikel! In je laatste stuk geef je aan dat een andere mythe volgens jou is dat Google AdWords invloed heeft op SEO. Kun je dit verder toelichten? Wij zien namelijk dat bij een aantal klanten de ‘hits’ via organische resultaten flink stijgen na het activeren van een AdWords campagne. Daarnaast lijkt het activeren van een AdWords campagne ook de (organische) posities in Google positief te beïnvloeden. Wat is jouw ervaring?

Nog een mythe: keyword density. Verbaast me nog steeds hoe vaak ik dat tegenkom.

Ik ben benieuwd wat jullie van de (SEO) stelling text to code ratio van minimaal 10% vinden. Deze pagina bevat trouwens een text to code ratio van 73,59%. Hoe belangrijk is het volgens jullie voor de ranking?

Dank Eric, voor je bondige reactie (en je blog).

Fijn om te zien dat dit niet een zoveelste standaard SEO-lijst is met altijd dezelfde punten! Dit zijn (op eerste gezicht althans) daadwerkelijk zaken die getest en onderzocht zijn, en waar eenvoudige SEO blogs al snel over schrijven dat het absoluut uit den boze is deze stategieën nog te gebruiken.

Bedankt voor de frisse blik.

Ik zou graag de titel gerectificeerd zien naar “Ontkracht: 10 SEO-mythes anno 2009”

Schitterend stuk Eduard!

Ben hier en daar ook even wakker geschud.

Heb je toevallig ook enig “opzienbarend” nnieuws over het linken van een 404 naar je homepage?

Goed verhaal, ik denk dat je daar de SEO-toekomst redelijk mee voorspelt.

Logisch denkwerk kom je een heel eind mee. Google is ook maar een algoritme 😉

Ik heb jammer genoeg mythe 5. Zomaar gezakt in de ranking. Iemand verdere uitleg over hoe het zomaar kan? Geen penalty o.i.d.

Interessant artikel. Zeker handig om dit eens duidelijk to the point op te schrijven. Vraagje over de indexatie via de toevoeging aan XML sitemaps.

Zijn er voor deze pagina’s geen extra meta gegevens meegegeven en is er geen tekst toegevoegd die de pagina’s meer verschillend maakt?

Mijn favorite myth: Je hebt 4000 woorden tellende heminway-kwaliteit content nodig met legitieme academische referenties om uberhaupt te ranken in de SERPs.

Natuurlijk zal ik nooit zeggen dat je geen goede content moet schrijven, maar sommige SEO blogs gaan echt te ver in kwaliteits richtlijnen.

Hi Eduard,

Goed stuk. Overigens is de pagerank wel geupdate, dit heb ik in ieder geval gemerkt bij mijn klanten. Dit gebeurde begin december.

Rik

Interessant stuk. Zeker punten waar je rekening mee moet houden. Maar wij hebben hetzelfde als Rik gemerkt. De pagerank wordt naar ons weten wel geupdate.

Marisse

Okay, duplicate content kan dus, maar de site die het origineel plaatste, scoort de eerste positie. Waste of time om het dus te gaan reposten.

@Ruud: die waste of time geldt toch alleen als dat reposten puur voor SEO-doeleinden is? Je kunt ook content reposten omdat het waardevol is voor je publiek. Niet geheel onbelangrijk, volgens mij.

Gevaarlijk verhaal omdat het veel halve waarheden bevat. Wat nu nog werkt of een beetje werkt kan over een paar maanden desastreuze gevolgen hebben. Het grote probleem van deze benadering, die veel SEO specialisten volgen, is dat het doel van SEO én de filosofie van Google totaal uit het oog wordt verloren.

Het gaat er niet om de trucjes te vinden of om de grenzen van Google ’s algoritme op te zoeken. Het gaat alleen maar over het bieden van de beste en meest relevante content voor mensen die daarnaar op zoek zijn. Google is voortdurend op zoek naar verbeteringen in het algoritme om dat te doen en alles wat daar niets mee te maken heeft te negeren.

Cloaking is niet in het belang van de gebruiker en daarom moet je het niet toepassen. Hetzelfde geldt voor dubbele content. Verder is er natuurlijk het simpele principe dat Google de content wel moet kunnen indexeren.

Volg je de filosofie van Google en richt je je op de gebruiker dan haal je hoge posities én zal je die houden, ook bij wijzigingen in het algoritme. Probeer je de trucjes te vinden die niet in het belang zijn van de gebruiker dan gaat het vroeg of laat fout.

Ik werk al jaren zonder tricks. Je weet gewoon dat ze vroeg of laat door een scan van google gevonden zullen worden en dan hebben de websites daar last van.

Een goede heldere website met waardevolle contant gaat vanzelf scoren.

erg leuk artikel!

Nu heb ik zelf nog een vraagje:) Is het betr om een blog(pagina) of een normale pagina te optimaliseren?

vaak wordt er gezegd dat een blog pagina minder wordt gevonden?

Is dat ook waar?

Na het lezen van jouw mening en nog een aantal anderen rond “Duplicate content” begin ik daar eigenlijk sterk in te geloven. Er zijn namelijk veel nieuwssites die gewoon nieuws overnemen van andere, en daar wel goed mee scoren…

Ik heb een lokale nieuwssite. Het lokale nieuws wordt regelmatig aangeleverd in de vorm van persberichten die – meer of minder herschreven – dus op mijn én andere nieuwssites terecht komt. En vaak ook nog op de site van de organisatie die het bericht verstuurde.

Is hier dan sprake van duplicate content? Of gaat het alleen om letterlijk dezelfde teksten?

bedankt !

Ik ben al een tijdje bezig met mijn website http://www.bymonow.com. Deze site is “SEO proof” maar ik krijg vaak de feedback dat ik moeilijker vindbaar ben dan een speld in een hooiberg. Zelfs bij het zoeken op mijn naam, MONOW! Heeft iemand tips om te zorgen dat ik wel op mijn eigen naam gevonden word? Alvast bedank!

Gerelateerde artikelen

Marketingfacts. Elke dag vers. Mis niks!

Marketingfacts. Elke dag vers. Mis niks!