Zo makkelijk is het om zelf een deepfake (of deepnude) te maken

Deepfakes komen steeds vaker in het nieuws, soms hilarisch, soms heel wat minder leuk: van Dionne Stax op PornHub tot gesproken statements van mensen die nep blijken te zijn. Tot voorheen was het terrein van de technologie alleen voor AI-ontwikkelaars en academici weggelegd, maar met de komst van allerlei nieuwe tools is het maken van deepfakes ineens voor iedereen mogelijk. En dat brengt gevaren met zich mee, want wat en wie kunnen we nog vertrouwen?

Sinds mijn rapport ‘Echt nep – van virtuele beroemdheden naar digitale mensen‘ (juli 2018) en ons onderzoek naar ‘The Synthetic Generation‘ (februari 2019), volg ik de ontwikkelingen omtrent synthetische media en met name die van deepfake-technologieën op de voet. Lees ook ons recente opinieartikel ‘Deepfakes zijn een groeiend gevaar voor onze democratie‘ in het Financieel Dagblad (juni 2019).

Met een deepfake-video wordt bedoeld dat met behulp van Artificial Intelligence het gezicht van iemands digitale evenbeeld kan worden gemanipuleerd, door bijvoorbeeld het digitaal te verouderen of een ander gezicht op een lichaam te knippen en te plakken. Vaak heeft dit hilarische video’s tot gevolg. Zoals Nicolas Cage die opeens de hoofdrol speelt in allerlei films waarin hij nooit geacteerd heeft. Of de video van Bill Hader die tijdens een imitatie van Tom Cruise opeens in Tom Cruise verandert. Helaas zitten er ook negatieve kanten aan deze technologie. Zo kwam voormalig nieuwslezers Dionne Stax onlangs zelf in het nieuws omdat er een seksvideo van haar op PornHub stond. Overduidelijk niet echt, maar toch kwam een handvol bezoekers aan hun trekken.

“Met de komst van allerlei nieuwe tools is deepfake-technologie voor iedereen binnen handbereik”

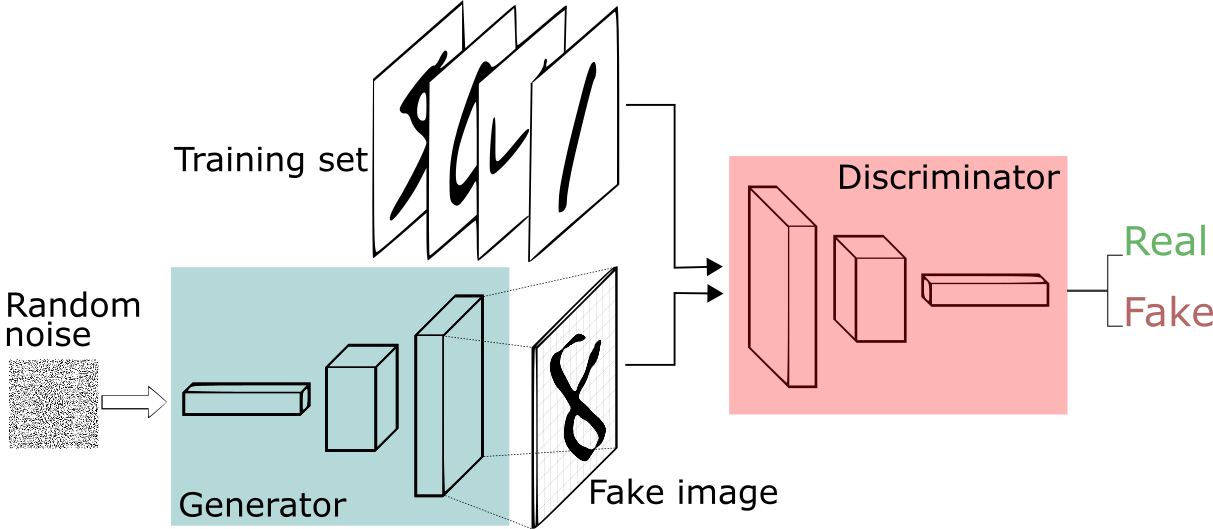

Tot op heden werden deepfake-video’s gemaakt met behulp van zogeheten Generative Adverserial Networks (GAN). Dit zijn twee neurale netwerken die met elkaar discussiëren over wat echt is en wat niet. Beide netwerken beschikken over dezelfde trainingsvoorbeelden. Het ene netwerk, de Generator, probeert op basis van deze voorbeelden, zelfstandig kopieën te maken. Het andere netwerk, de Discriminator, toetst de echtheid van de gegenereerde proeven tegen de bestaande gegevensverzameling. De één probeert de ander dus voor de gek te houden en de ander wil daar juist niet intrappen. Zie het als een kunstvervalser die voortdurend een kunstdetective met zijn nieuwste kunstwerk probeert te misleiden. In dit proces van hoor en wederhoor geven de beide netwerken elkaar voortdurend feedback, tot beide netwerken het met elkaar eens zijn dat de kopie niet van echt te onderscheiden is (en daarmee origineel is) en aan de oorspronkelijke dataset mag worden toegevoegd. Het is een uiterst succesvol voorbeeld van leren zonder supervisie.

Het aantal toepassingen op basis van GAN-technologie is in de afgelopen paar jaar geëxplodeerd. Zo zijn er GAN’s die anime karakters produceren, die bepaalde poses voor modellen genereren, die schilderstijlen van het ene domein op het andere domein toepassen, mode-ontwerpen, foto’s met een lage resolutie kunnen omtoveren in foto’s met hoge resolutie, lege plekken in foto’s kunnen opvullen, tekst kunnen omzetten in beelden en gezichten kunnen verouderen. Deze competitieve netwerken kunnen zelfs complete appartementen inrichten. Zo heeft iemand de website thisrentaldoesnotexist.com opgericht, waarbij het lijkt alsof je appartementen op Airbnb aan het bekijken bent, maar in werkelijkheid is alles wat je ziet hartstikke nep en door een neuraal netwerk gecreëerd.

Zelf een deepfake maken

Tot voorheen was het terrein van GAN-technologie alleen voor AI-ontwikkelaars en academici weggelegd. Met de komst van allerlei nieuwe tools komen de mogelijkheden van deepfake-technologie voor iedereen binnen handbereik. Een goed voorbeeld hiervan is FaceApp, waarmee je een oudere of jongere versie van jezelf kunt maken of zelfs van geslacht kunt veranderen.

“Voor het creëren van deepfakes is helemaal geen deepfake-technologie meer nodig”

Zelf ben ik de afgelopen week samen met collega Thijs Pepping met de tool EbSynth aan de slag gegaan. Deze is gratis te downloaden en een uitgebreide uitleg van deze app kun je op YouTube bekijken. Met de tool kun je een bepaalde stijl aan een film voegen. Het enige wat je hoeft te doen is een frame uit de oorspronkelijk film selecteren, deze aanpassen aan de stijl die je wilt hebben, en vervolgens laat je de app aan de hand van het frame alle andere frames aanpassen. De resultaten zijn verbluffend voor een applicatie van zo’n 8Mb groot.

Het eerste wat ik deed was een fragment uit het programma Jinek Live knippen om een frame met daarin Eva Jinek zelf te bewerken. Ik besloot om Eva te verouderen. De frame (oftewel een enkele foto uit de film) bewerkte ik met FaceApp en vervolgens gebruikte ik EbSynth om het gehele fragment aan deze frame aan te passen. Het resultaat zie je hieronder. Het filmpje dat ik gebruikte duurt slechts 7 seconden en bevatte zo’n 140 frames. Mijn Macbook Pro had er ongeveer een uur voor nodig om de verouderde Jinek te genereren.

Vervolgens ging ik aan de slag met een fragment waarin Matthijs Nieuwkerk en Eva Jinek naast elkaar zaten. Matthijs maakte ik jonger en Eva maakte ik wederom ouder. Het resultaat kun je hieronder zien.

Tot slot nog een video waarin ik mijn eigen gezicht heb geswapt. Als bronmateriaal gebruikte ik een recent Instagram-filmpje van Katja Schuurman. Ook hier is slechts één keyframe gebruikt en de instellingen van Ebsynth op default laten staan. Mijn verwachting is dat ik de kwaliteit hoger krijg als ik met deze instellingen ga spelen.

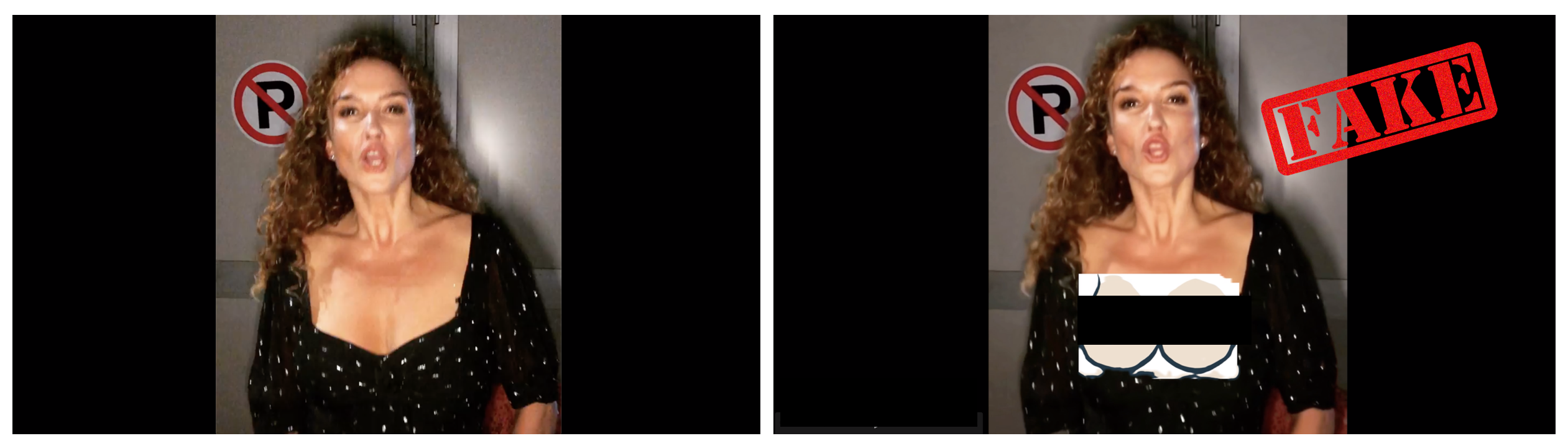

Zelf een deepnude maken

Tot slot wilde ik weten of het ook mogelijk was om een deepnude te maken. Hiervoor misbruikte ik oude beelden van Yvon Jaspers. Op haar plakte ik twee borsten van een willekeurig naaktmodel. Het eindresultaat was primitief, maar het werkte. Zelfs haar handen, die ze even langs haar lichaam bewoog, verstoorden het gemanipuleerde beeld niet.

“Het maken van deepfake-porno is net zo makkelijk als het gebruiken van een Instagram-filter”

Ook het Instagram-filmpje van Katja Schuurman bewerkte ik, hier plakte ik haar eigen borsten uit de Playboy op en het resultaat was verbluffend. Zelfs met getekende borsten werkt het. Je ziet duidelijk dat het filmpje niet echt is, maar geef de tool nog wat ontwikkelingstijd en een kind kan de was doen.

Hardcore nerds zullen duiden dat het hier om een shallowfake gaat, en niet om een deepfake. Punt is dat je voor het creëren van deepfakes helemaal geen deepfake-technologie meer nodig hebt. Het kan straks zelfs real-time. Het maken van deepfake-porno is net zo makkelijk als het gebruiken van een Instagram-filter. Relaties zullen sneuvelen, mensen zullen gechanteerd worden en de slachtoffers van deze technologie zullen met name vrouwen zijn.

Deepfake voor stemmen

Deepfake-technologie hoeft niet alleen gebruikt te worden voor beelden, het kan ook ingezet worden om iemands stem na te bootsen. Dit overkwam recentelijk Jordan Peterson, hoogleraar psychologie in Toronto, YouTube-grootheid en auteur van het zelfhulpboek ’12 regels voor het leven’. Als gevolg van zijn werk is zijn stem overal op het internet terug te vinden. Het bedrijf Coding Elite maakte hier al eens dankbaar gebruik van door een vocal avatar van zijn stem te maken en hem het nummer ‘Lose Yourself’ van Eminem te laten rappen. Deze week werd de website notjardanpeterson.com in het leven geroepen, waarbij iedereen een tekst kon intikken, om vervolgens de stem van Peterson te horen die de tekst voorlas. Niet van echt te onderscheiden. De grap veranderde al snel in treiterij. Gebruikers lieten hem de meest vreselijke dingen zeggen.

“We scheppen met deepfake-technologie een wereld waarin we onze ogen en oren niet langer kunnen vertrouwen”

In een opinieartikel maakte de echte Peterson het punt dat we serieus moeten overwegen dat “iemands stem een integraal onderdeel is van zijn identiteit, van zijn realiteit, van zijn persoon – en dat het stelen van die stem een criminele daad is, ongeacht de intentie.” Dat de achterliggende bedoeling niet altijd goed is, blijkt ook uit de waarschuwing van online beveiligingsbedrijf Symantec. Zij kennen drie gevallen waarbij deepfake-audio van CEO’s werd gebruikt om accountants te overtuigen om geld over te maken.

Conclusie

Het internet levert een bonte verzameling aan feiten, filters, meningen, verzinsels en samenzweringstheorieën op waarbij opinies, emoties en onderbuikgevoelens belangrijker zijn dan feiten en ratio. Nu scheppen we met deepfake-technologie een wereld waarin we onze ogen en oren niet langer kunnen vertrouwen. Het grote gevaar is niet zozeer dat de leugen tot waarheid wordt verheven, maar dat de geloofwaardigheid van de waarheid wordt aangetast. Als we een toekomst tegemoet gaan waarin alles en iedereen kan worden nagemaakt en nagebootst, dan is niets meer echt, alles kan immers als een leugen of nep nieuws worden afgedaan. Wie of wat moeten we dan nog vertrouwen?

“Het grote gevaar is dat de geloofwaardigheid van de waarheid wordt aangetast”

Recent onderzoek van Pew Research toont aan dat twee derde van de ondervraagde Amerikanen gemanipuleerde beelden en video’s als een groot probleem ervaren om de basisfeiten achter actuele gebeurtenissen te begrijpen. Meer dan een derde zegt dat ‘verzonnen nieuws’ hen ertoe heeft gebracht om de hoeveelheid nieuws die ze in het algemeen consumeren, te verminderen. Ze hebben een apathie voor de realiteit ontwikkeld. We verlaten hiermee het post-truth tijdperk en komen terecht in dat van de post-realiteit. De fundamenten van onze samenleving komen hiermee onder druk te staan. Deze is immers gebaseerd op één gedeelde versie van de werkelijkheid en met deze technologie heeft iedereen de mogelijkheid om zijn eigen versie van de realiteit te creëren.

Ondanks dat ik ook wel zie dat dit soort technologie ontzettent ontwrichtend kan werken heb ik ook hoop. Het is namelijk natuurlijk ook zo dat de technologie die word ingezet om dingen te manipuleren ook kan worden ingezet om gemanipuleerd materiaal te herkennen. Linksom of rechtsom zullen er voorlopig nog kleine “littekens” door software te ontwaren zijn die echt en nep onderscheiden. Implementatie van dit soort reverse-engineering software zal op zich laten wachten tot er een handje vol grote schandalen uitpakken, maar ik heb hoop.

Ik snap de bezorgdheid wel omtrent deze techniek maar laten we eerlijk zijn liegen, bedriegen, oplichting etc etc etc zijn de dagelijkse gang van zaken van putjeschepper tot minister ze maken zich allemaal schuldig aan deze praktijken. Dus ik zie niet in waar deze techniek een groot verschil zal maken in onze huidige samenleving.

Natuurlijk zal het een extra dimensie toevoegen aan oplichting, liegen en bedriegen en er zullen weer mensen rijk worden door deze techniek ook zullen mensen gedupeerd worden door deze techniek maar een schokkende verandering zal het niet teweeg brengen een verschuiving op zijn hoogst.

Patricia P. had wellicht slimmer moeten zijn en haar video’s aan deze techniek moeten wijten om ook maar een voorbeeld te noemen van positief resultaat door deze techniek.

Door de linkjes naar de software en de instructions te bekijken lijkt dit geen oplossing voor langdurige vertellingen. Het neemt de ambachtelijke animator natuurlijk veel werk uit handen maar elk shot is al snel een paar uur werk. Met deze techniek een dagelijkse soap tot stripverhaal te bewerken zal nog steeds weken duren. Dat lijkt mij het paard achter de wagen spannen… (Ik vond het al raar dat de software gratis wordt aangeboden). Maar voor kwaadwillenden die nieuws-snippets willen maken die viral gaan is het natuurlijk geweldig. Twee avondjes kloten en je hebt een rel. En de reclamebureaus hoeven geen sterren en modellen meer in te huren…

Door de linkjes naar de software en de instructions te bekijken lijkt dit geen oplossing voor langdurige vertellingen. Het neemt de ambachtelijke animator natuurlijk veel werk uit handen maar elk shot is al snel een paar uur werk. Met deze techniek een dagelijkse soap tot stripverhaal te bewerken zal nog steeds weken duren. Dat lijkt mij het paard achter de wagen spannen… (Ik vond het al raar dat de software gratis wordt aangeboden). Maar voor kwaadwillenden die nieuws-snippets willen maken die viral gaan is het natuurlijk geweldig. Twee avondjes kloten en je hebt een rel. En de reclamebureaus hoeven geen sterren en modellen meer in te huren…

Ik zou willen pleiten voor een nieuw veilig internet waar alleen echte geverifieerde informatie te vinden is.

Ik sluit me aan bij OiraM!

Sowieso absurd dat we ál onze belangrijke informatie, waaronder whatsappgesprekken (ook van ministers) in handen geven en op servers zetten van Amerikaanse bedrijven. Een zorgwekkende ontwikkeling; niets of niemand zou je zo veel macht moeten geven.

Waar blijven de landelijke (of op zijn minst Europese) alternatieven?

Gerelateerde artikelen

Marketingfacts. Elke dag vers. Mis niks!

Marketingfacts. Elke dag vers. Mis niks!