Waarom engagement op social media niet de heilige graal is

.jpg)

Disrupt the data, want algoritmes hebben niet het beste met ons voor

Wie iets weet van social media-algoritmes, weet dat ‘engagement’ meestal als heilige graal wordt beschouwd. Algoritmes bepalen wat jij ziet op basis van waar je naar gekeken hebt – en waar je actief op hebt gereageerd. Maar is dat wel het juiste criterium om te voorspellen wat jij graag wilt zien? Wat als het anders kan?

Ik las de afgelopen zomer een fantastisch boek over social media: ‘The Hype Machine‘. Ik probeer nu de tijd te vinden om het nog een keer te lezen, want ik heb zelden een boek gelezen dat mijn kennis zo verdiepte en verbreedde. Het is net alsof het alles wat ik weet in een nette puzzel heeft gestopt waarbinnen ik alle stukjes nu kan leggen. De randen zijn nu ingevuld, zeg maar.

Net wat meer handen en voeten

‘The Hype Machine’ staat bomvol met wetenschappelijke inzichten en onderzoeken die een scala aan aspecten van social media beslaan. Van advertenties, netwerktheorie en psychologie tot technische dingen als algoritmes en AI en het design van al die apps. En dat geeft alles toch net wat meer handen en voeten.

Als ik een presentatie geef over social media, begin ik vaak met het uitgangspunt:

- Dat iedere social media-app een strijdtoneel is waar aandacht het hoogste goed is;

- Dat algoritmes bepalen of jouw bericht die aandacht krijgt; en

- Dat algoritmes varen op jouw gedrag in de app – likes, time on page, reacties, shares, op wie je reageert, op wat je reageert enzovoort.

Als je dat begrijpt, begrijp je de basis. En dan kun je na gaan denken over wat je wilt bereiken en hoe je dat gaat doen. Dus dat is top. Maar er is zoveel meer. En het kan zo anders.

Want ik ben dol op social media, maar het vervelende is dat die algoritmes niet het beste met ons voor hebben. Iemand programmeert ze en iemand wil er iets aan verdienen. En die iemanden zijn ons als gebruikers geen verantwoording verschuldigd.

Daarom is het doel van die algoritmes nooit om jou als gebruiker gelukkig te maken of je leven te verbeteren. Al zou het dat wel kunnen zijn.

Ook Facebook geeft het toe

Zo langzamerhand lijkt Facebook dit ook toe te geven, zoals in dit fascinerende artikel op Wired te lezen is. Daarin wordt dit recente blog van Facebook besproken over een onderzoek naar de rol van politieke content in de news feed, door Facebook zelf.

Het is eerlijk gezegd een wonder dat de journalist dat Facebookblog heeft gevonden. Want Facebook heeft weliswaar redelijk transparant de resultaten van dat onderzoek gedeeld, maar dan wel in de vorm van een update van een oud blog uit februari 2021. Het is maar goed dat al die technologiejournalisten zo goed opletten.

Het Facebookblog gaat over een onderzoek waarbij Facebook een kleine groep Facebookgebruikers in een beperkt aantal landen minder ‘politieke content’ ging laten zien om te kijken of dat hen tevredener zou maken over Facebook. Het is tenslotte het grote kritiekpunt dat zowel journalisten als gebruikers op Facebook hebben: de polariserende werking en bovenmatige impact van politieke berichten op Facebook.

Daarnaast wilde Facebook onderzoek doen naar ‘andere signalen’ (dan de gebruikelijke ‘engagement’) om te bepalen of gebruikers politieke berichten wilden zien. Dus niet alleen ging het algoritme voor deze groep gebruikers minder politieke content tonen, het ging ook op zoek naar alternatieve manieren om te bepalen wat mensen wel en niet wilden zien.

Slim van Facebook om nu eens niet alleen op de data te vertrouwen

Het klinkt vaag, maar zoals de journalist van Wired terecht zegt is het redelijk baanbrekend. (Belangrijke notitie: berichten van officiële overheidspagina’s, de WHO en andere officiële gezondheidsorganisaties over covid waren uitgesloten van de test en werden niet ‘onderdrukt’ in het algoritme.)

Gebruikers in de testgroepen zouden bovendien vragenlijsten krijgen over hun nieuwe, minder politieke, news feed. Om te zien of het ze beviel. Slim van Facebook om nu eens niet alleen op de data te vertrouwen.

Veel engagement met politieke content

Zoals je misschien weet zijn politieke berichten het soort content dat van alle type berichten op Facebook tot de hoogste ‘engagement’ leidt. Mensen voelen zich bij uitstek boos, opgewonden of verdrietig bij berichten over de politiek van hun land. En omdat het algoritme van Facebook ‘engagement’ als belangrijkste factor neemt om te voorspellen of nieuwe berichten getoond moeten worden, zijn dat al jaren de berichten die het grootste bereik krijgen.

De meest polariserende, opruiende politieke content krijgt het meeste bereik

Het is precies waarvoor Facebook onder vuur ligt: de meest polariserende, opruiende politieke content krijgt het meeste bereik.

Als je wilt weten hoe dit komt, moet je echt ‘The Hype Machine’ lezen, want daar staat het precies in uitgelegd. Er is bijvoorbeeld een reden dat nieuws ons meer raakt dan andere content. Er is ook een reden dat ‘fake news’ ons eerder bereikt dan andere berichten. Er zijn gewoon heel veel factoren die er toe leiden dat al dat politieke nieuws onze Facebook tijdlijn overneemt.

Maar de vraag die Facebook wil beantwoorden is: kan het ook anders? Kan Facebook die loop waarbij we steeds meer ‘engagement’ laten zien bij bepaalde nieuwsberichten, we er daardoor steeds meer van te zien krijgen, en daardoor steeds ongelukkiger worden, doorbreken?

Weet Facebook wel wat we echt willen?

Een app kan niet in je hoofd kijken, natuurlijk, of in je hart. Maar Facebook heeft zoveel meer dan onze ‘likes’ en ‘reacties’ om op af te gaan om ons gedrag en onze voorkeuren te analyseren. Ik denk soms dat mensen zich niet realiseren wat Facebook allemaal bijhoudt en weet over ons en hoeveel data dat genereert. Het gaat niet alleen om je profiel, je netwerk en de mensen en pagina’s die je volgt, maar ook de plekken waar je komt, het aantal seconden dat je naar video’s over honden kijkt, en nog veel en veel meer.

Een like is niet alles

Als je dan die artificiële intelligentie loslaat op bakken en bakken met data en gedragsgegevens, zou dat moeten kunnen leiden tot geavanceerde voorspellingen, zou je denken. Vooral als je je gaat realiseren dat een ‘like’ niet alles is.

Zoals de journalist van Wired zegt: als je een bak dorito’s voor mijn neus zet als ik op de bank zit, ga ik hem leegeten. Maar dat wil niet zeggen dat ik niet liever andere keuzes zou hebben gemaakt en andere dingen zou hebben willen eten.

The same goes for Twitter, where I routinely allow myself to be enraged by tweets before recognizing that I’m wasting time doing something that makes me miserable.

Als Facebook uit alle data die wij genereren door ons gebruik van de app ook patronen kan ontdekken – of ‘signalen’ zoals ze zelf zeggen – die correct voorspellen wat we nou wél willen zien, waar we wél blij van worden, welke berichten nou wél bijdragen aan ons leven, zou dat baanbrekend zijn.

Wat dat dan zou zijn, vraag je? Geen idee. Misschien iets van vragen als:

- Leiden berichten tot contact met je geliefden?

- Leiden berichten tot positief gedrag … ga je een ander soort berichten delen of liken of doorsturen, berichten waarvan duidelijk is dat die iets bijdragen?

- Leiden berichten tot reacties waarvan al die slimme AI-systemen vaststellen dat ze positief zijn en bijdragen aan de community?

Het is nogal lastig, he (en het verdient een ander blogartikel en flinke discussie!). Want de vraag is niet alleen wie bepaalt of iets waarde heeft en bijdraagt aan ons leven. De vraag is vooral ook hoe je dat nou kunt zien aan ons gedrag in zo’n app. Wat doe je in die Facebook-app als je happy en gelukkig bent? En wat doe je niet? Op welke signalen moet Facebook dan letten? Het is voer voor psychologen.

Het zoeken is naar de signalen

Terug naar het experiment en Facebooks vage statement dat er misschien toch andere signalen zijn dan de traditionele ‘engagement’ om te bepalen wat mensen willen zien:

We’ve also learned that some engagement signals can better indicate what posts people find more valuable than others. Based on that feedback, we’re gradually expanding some tests to put less emphasis on signals such as how likely someone is to comment on or share political content. At the same time, we’re putting more emphasis on new signals such as how likely people are to provide us with negative feedback on posts about political topics and current events when we rank those types of posts in their News Feed.

Wat interessant is, is dat Facebook aangeeft dat ‘engagement’ niet altijd gelijk staat aan ‘value’. Zie je dat? Je moet er voor tussen de regel lezen, zoals de journalist van Wired opmerkt. Maar baanbrekend is het niettemin.

Even een terzijde voor de mensen onder ons die dagelijks proberen om meer bereik te krijgen op Facebook zonder daar voor te betalen met advertenties: Facebook zegt hier ook heel duidelijk dat ze meer waarde gaan hechten aan ‘negatieve feedback’ op berichten.

Negatieve feedback kan bestaan uit boze gezichtjes in plaats van blije duimpjes. En uit acties als ‘bericht verbergen’ of ‘deze auteur 30 dagen lang snoozen’, knoppen die je nu al kunt gebruiken. Maar misschien zijn er ook andere acties die negatieve gevoelens aangeven (voer voor psychologen, weet je nog?).

Je zou denken dat dit niet nieuw is, negatieve feedback meewegen, maar dat is het wel degelijk.

LinkedIn let nu ook heel sterk op ‘negatieve feedback’

Ik las laatst dat LinkedIn (nu?) ook heel sterk let op ‘negatieve feedback’, in de zin van knoppen die je aan kunt klikken als je iets of iemand niet leuk vindt. Ontvolgen, disconnecten, rapporteren … die dingen zijn geen goed nieuws. En ze moeten meegewogen worden in het algoritme, wil je een goed beeld krijgen van hoe een bericht overkomt bij mensen. Kijken naar likes, shares en reacties is niet genoeg.

Het laat zien dat gedrag in de app iets betekent. En dat social media-apps beter moeten worden in begrijpen wat dat gedrag betekent.

Jammer

Het is jammer dat we zo weinig concrete informatie krijgen over het experiment van Facebook. Hoe lekker zou het zijn als je er zelf in kon duiken …? Maar wat hier goed aan is, is dat al die vragen nu eens gesteld worden. En dat de experimenten worden uitgevoerd. Misschien is het wel de eerste stap naar een hele andere social-mediawereld.

Als die algoritmes anders worden en het design verandert, zou wat we voelen en wat de impact is van social media-apps als Facebook wel eens totaal anders kunnen worden.

In hoofdstuk 12 in ‘The Hype Machine’ zegt auteur Sinan Aral:

What if the hype machine’s design wasn’t geared towars likes that give us a fleeting dopamine rush to induce us to produce more of the most popular content, but instead incentivized us to produce the most valuable, uplifting, motivating, or thought-provoking content?

(The Hype Machine is zijn term voor – kort door de bocht – het hele systeem van social-medianetwerken: ‘the real-time communications ecosystem created by social media‘). Wat, zegt hij, als de reputatie en invloed (en het bereik) van influencers niet aan populariteit gekoppeld was, maar aan de vraag of ze ons in aanraking brengen met nieuwe ideeen, of de meeste steun bieden, of ons helpen slechte gewoontes te doorbreken?

Wat als je een ‘trust’-knop hebt in plaats van een duimpje en een boos gezichtje?

Wat als je een ‘trust’-knop hebt in plaats van een duimpje en een boos gezichtje? Sinan Aral in hoofdstuk 10 in zijn boek:

What if every time we posted content to social media we were given the option to relate hoe ‘confident’ we were in the material, or if we were asked whether we thought other people’s posts were true?

En dat geldt niet alleen voor de mensen die daadwerkelijk berichten plaatsen (want dat doet lang niet iedereen). Het gaat ook om het gedrag van de mensen die die berichten versterken en verspreiden door er op te reageren en ze te delen.

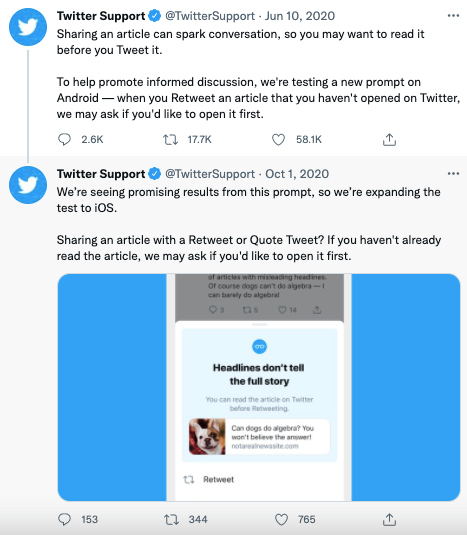

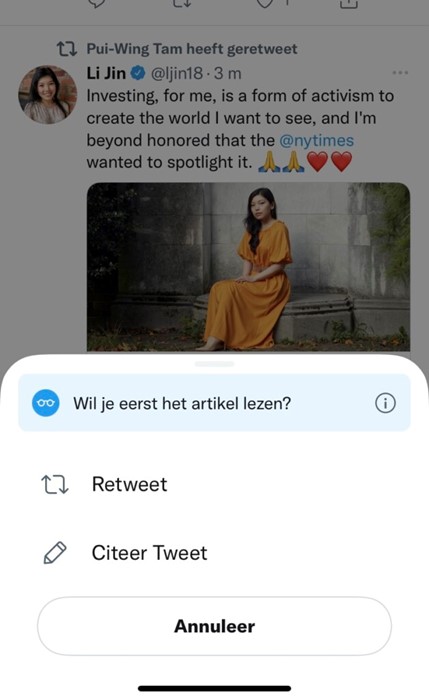

In 2020 startte Twitter met een experiment dat hier een mooi voorbeeld van is. Als Twitteraars die de Android-app gebruikten op het punt stonden een tweet met daarin een link te retweeten en ze hadden niet op de link geklikt, kregen ze eerst de vraag of ze het zeker wisten:

(Klik op de afbeelding om naar de tweet te gaan)

Inmiddels heeft de iPhone-app deze prompt ook:

Ik kan nergens vinden wat de uitkomsten van deze notificatie/prompt zijn, maar hij zou best eens impact kunnen hebben. Het is in ieder geval een voorbeeld van hoe je een app zo kunt inrichten dat je negatieve gevolgen – waaronder de snelle verspreiding van fake news en misinformatie – kunt helpen tegengaan.

Minder content, minder aandacht

Het is maar afwachten hoe dit uitpakt. De vraag is of Facebook gemotiveerd genoeg is om de waterval van troep te gaan voorkomen en de kwaliteit van wat mensen zien te verbeteren. Het zal ongetwijfeld leiden tot veel minder content, dus veel minder aandacht. En de angst is natuurlijk dat dit ertoe leidt dat minder mensen in de app aanwezig zijn en er minder kansen zijn voor het verkopen van advertenties.

Gelukkig kunnen we hier zelf ook een rol in spelen (ook een conclusie die ik deel met Aral). Wij kunnen zelf bij het gebruik van social media:

- Bewuster kiezen we volgen

- Meer aandacht besteden aan reageren

- Zorgen dat we niet zo maar andermans berichten delen/retweeten

- Mensen en bedrijven die ons een slecht gevoel geven direct ontvolgen (of dempen, als het om je nichtje/buurman/oude kennis gaat… ze hoeven het nooit te weten te komen!)

Als ik mensen spreek van onder de 20 jaar en we hebben het over Instagram, vraag ik ze altijd of ze zich wel eens rot voelen bij het zien van al die berichten van vrienden en vriendinnen die mooi weer spelen. Het antwoord is altijd ‘ja’. En dan raad ik ze aan om die mensen gewoon uit hun timeline te verwijderen, door ze te dempen of te ontvolgen. Niets dat je een rotgevoel geeft, verdient het om in je timeline te blijven. Zo simpel is het.

Niets dat je een rotgevoel geeft, verdient het om in je timeline te blijven

Als wij zelf kritisch blijven, scheelt het al een hoop. Want die algoritmes hechten waarde aan wat wij doen. Disrupt the data en wees bewust in wat je doet. Hopelijk gaan die algoritmes onder druk van de publieke opinie dan eindelijk doen wat ze in potentieel kunnen: mensen verbinden en verrijken.

PS Ik had nog wel dagen aan dit artikel kunnen schrijven. Maar ik doet het niet want dan wordt het nooit gepubliceerd.