Hoe betrouwbaar zijn webstatistieken? (Deel 2)

Verschillen in webstatistieken leiden regelmatig tot vragen over de betrouwbaarheid van de data. De migratie naar een ander pakket, het ‘toevallig’ vergelijken van de statistieken met data uit andere pakketten en het afrekenen van advertentiecampagnes kunnen hierdoor aanleiding geven tot veel discussie.

Verschillen in webstatistieken leiden regelmatig tot vragen over de betrouwbaarheid van de data. De migratie naar een ander pakket, het ‘toevallig’ vergelijken van de statistieken met data uit andere pakketten en het afrekenen van advertentiecampagnes kunnen hierdoor aanleiding geven tot veel discussie.

TNO heeft in samenwerking met Blue Mango, ClickValue, Maximum en Netprofiler onderzoek gedaan naar de betrouwbaarheid van webstatistieken. Belangrijke vragen hierbij waren in welke mate verschillen reëel en acceptabel zijn, hoe de betrouwbaarheid van webstatistieken voor een specifieke implementatie van statistieken te bepalen is.

Samenvatting van de belangrijkste conclusies

– Verschillen in WA statistieken zijn een ‘fact of life’

– Verschillen zijn een optelsom van vele details. Kijk daarom naar gelijke trend. Als de trend niet overeenkomt, onderzoek de implementatie

– WA data is niet te vergelijken met STIR en Dart data

– Voor verschillen geldt een maximale ‘acceptabele afwijking’

– Afwijkingen groter dan het acceptabel percentage geven misleidende informatie => laat een audit doen om onterechte conclusies te voorkomen!

Aanpak project: Verschillen In Webstatistieken

Een stevige basis om de verschillen inzichtelijk te maken is vorig jaar gelegd door Stonetemple door middel van het Shootout rapport. In samenwerking met online marketing experts van Blue Mango, ClickValue, Maximum en Netprofiler startte TNO in de tweede helft van 2008 een project om in verder detail de verschillen en metingen van webstatistieken inzichtelijk te maken en een beeld te krijgen van de betrouwbaarheid van de data. De aanpak hiervoor bestond uit twee soorten onderzoeken.

Ten eerste werd van diverse grotere Nederlandse websites de statistiekdata samen met STIR en Dart geanalyseerd. Aan deze analyse werkten onder andere Agis, Ilse Media, Typhone, Univé Verzekeringen en TNO mee.

Om extra inzicht te krijgen in de verschillen en de oorzaken van deze verschillen, zijn ten tweede in een gesloten website omgeving testen met verschillende webstatistiek pakketten uitgevoerd. In de gesloten omgeving werd het verkeer gereguleerd en waren variabelen zoals het klikgedrag, IP-adressen en browser types instelbaar.

De pakketten die zijn getest in de gesloten omgeving zijn Google Analytics, Sitestat en Webtrends. Daarnaast zijn in de data analyse van sommige sites ook de pakketten HBX en SpeedTrap meegenomen inclusief Dart en STIR data.

De verschillen tussen metingen van pakketten op een website zijn onderling constant

Uit de analyses blijkt dat de gemeten waarden door de diverse websitestatistiek pakketten onderling soms zeer verschillen. De richting en de mate van de trends voor het aantal bezoekers, bezoeken en pageviews blijken sterk overeen te komen. Dit betekent dat de onderlinge verschillen tussen de pakketten over langere periodes constant blijven.

Maar hoewel de verschillen tussen metingen constant blijken, is dit verschil niet voor iedere website hetzelfde. Statistiekpakket A dat op de ene website structureel hogere waardes geeft dan pakket B, kan op een andere website juist lagere waardes geven. Belangrijke oorzaken hiervan blijken te liggen in de content en structuur van de website.

Welke mate van verschillen is reëel en acceptabel?

Een belangrijke conclusie uit het onderzoek is dat uit de analyses blijkt dat de waarden van de webstatistiek metingen ‘normaal’ verdeeld zijn. Daarnaast blijkt uit de analyse dat voor de spreiding van statistieken uit goed geconfigureerde pakketten een bovengrens is aan te geven. Deze statistische eigenschappen geven concrete vuistregels voor ‘acceptabele’ of ‘reële’ afwijkingen. Hierdoor kunnen website (statistiek) beheerders eenvoudig de betrouwbaarheid van de implementatie van webstatistieken controleren, door het percentage verschillen tussen de pakketten te vergelijken met het aantal pakketten dat je gebruikt. Als niet wordt voldaan aan de richtlijnen, dan wijst dit in de praktijk op implementatiefouten of incidenten waardoor significante verschillen optreden.

Deze controle is zowel te gebruiken voor grote als kleine websites omdat uit het onderzoek blijkt dat het aantal bezoekers, bezoeken en pageviews geringe invloed op de resultaten heeft.

Controleer hier de betrouwbaarheid van jouw webstatistieken

Hierdoor is het voor websites waarop twee of meer pakketten tegelijk worden gebruikt is relatief eenvoudig te bepalen of statistieken goed geïmplementeerd zijn. Daarnaast loont het de moeite voor websites met 1 pakket om een extra (gratis) pakket als Google Analytics te implementeren om deze controle te kunnen doen.

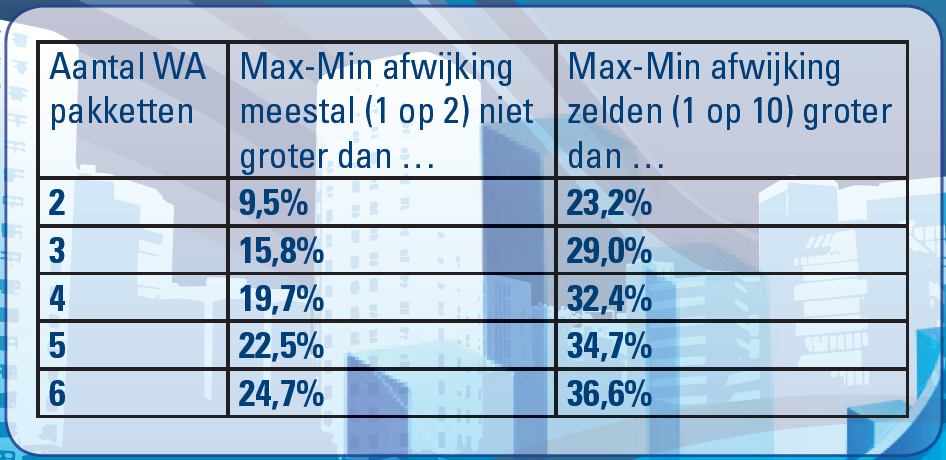

Voor de betrouwbaarheidscheck gelden de volgende richtlijnen:

- Bepaal aan de hand van de statistiekdata op week of maandniveau voor een paar periodes het procentuele verschil in visits, visitors en/of page views tussen het pakket met de hoogste en het pakket met de laagste waarde.

- Selecteer in onderstaande tabel de rij met het aantal pakketten dat je op je site hebt draaien.

- Is het door jou vastgestelde percentage voor meerdere periodes groter dan het percentage in de kolom “Max-Min afwijking zelden groter dan”, dan is de kans groot dat de implementatie van de WA pakketten dusdanig verschilt (b.v. tags van één pakket staan niet op alle webpages) dat de interpretatie van de data onvergelijkbaar is. Laat in dit geval de implementatie door de ICT afdeling of je Analyticsbureau kijken, of overweeg een audit.

Uiteraard helpen we je graag om de betrouwbaarheidscheck uit te voeren. {encode=”martijn.staal@tno.nl” title=”Laat dit ons dan even weten”}.

Dart en STIR data zijn niet vergelijkbaar

Naast een onderzoek van de webstatistieken zijn voor sommige websites ook de Dart en STIR data onderzocht. Het vermoeden dat deze data niet met de webstatistiekendata vergelijkbaar zijn, wordt door het onderzoek bevestigd. Doordat er andere doelstellingen en analysemethodes worden gebruikt zijn de absolute data en trends nauwelijks vergelijkbaar.

Oorzaken van verschillen in WA pakketten

In de gesloten testomgeving is een aantal oorzaken verder onderzocht. Basis hiervoor vormde een niet-uitputtende lijst van oorzaken (zie ook uitgebreider overzicht).

Door van tevoren ingesteld verkeer over enkele van de buitenwereld afgeschermde webpagina’s te leiden, ontstond meer inzicht in de verschillende manieren van meten van de WA pakketten. Hieruit bleek dat de pakketten in hoge mate hetzelfde werken, en dus in principe dezelfde getallen moeten geven. De verschillen die toch ontstaan blijken deels veroorzaakt te worden door het niet meetellen van pageviews door Webtrends bij het gebruik van de back-pijl in de browser. Daarnaast is geen van de pakketten in staat om het verkeer dat afkomstig is van webbots volledig uit te filteren.

In het algemeen constateren we dat de afwijkingen vooral worden veroorzaakt door de grote hoeveelheid aan relatief kleine oorzaken. Het verklaren van alle oorzaken is hierdoor erg complex, vandaar dat de aandacht vooral uit moet gaan naar een goede implementatie van de pakketten.

Presentatie met resultaten

De resultaten van het onderzoek zijn op woensdag 25 maart gepresenteerd tijdens een meeting van Web Analytics Association Nederland. De presentatie is te downloaden via de TNO website.

Voor meer informatie over het project kun je contact opnemen met een van de projectdeelnemers: Bart Manders van Blue Mango, Daniël Markus van ClickValue, Corné Wielemakers van Maximum, Simone Rodewijk van Netprofiler en ondergetekende.

De tijd die mensen op een site doorbrengen zie ik bij de statistieken nergens terug. Jammer!

Martijn, wat bedoel je? Zou je hier verschillen in verwachten?

We hebben ons in de test inderdaad moeten focussen, en hebben ervoor gekozen om de belangrijkste metrics (nl. pageviews, bezoeken en bezoekers) te nemen. Eventueel vervolg is dat je in verdere details duikt rondom o.a. de tijd etc.

Maar nogmaals: ik ben benieuwd vanwaar je interesse daar ligt.

@ Martijn Lafeber: Ik vraag me af hoe betrouwbaar die statistieken kunnen zijn (de tijd die mensen doorbrengen op een site). Er zit namelijk een groot verschil tussen een website nog ‘open’ hebben staan en er daadwerkelijk mee bezig zijn.

Als in de stats staat dat mijn site gemiddeld 10 minuten wordt bekeken, terwijl 9 op de 10 bezoekers hem een middagje in een ongebruikt venster heeft staan, krijg ik een verkeerd beeld.

Waaro zijn de trends in STIR data niet vergelijkbaar? Bedoelen jullie hiermee hun panelonderzoek?

Als (ook) hun webmeter word bedoeld, vereist dat wel wat meer uitleg. Want die gebruikt “gewoon” Nedstat, een met Webtrends en Google Analytics vergelijkbare methode. En zou dus in trends wel vergelijkbaar moeten zijn.

@Ruben: de STIR data betreffen inderdaad het gepubliceerde aantal bezoeken uit het panel-onderzoek. Het betreft een andere meetmethode dan WA (en met een ander doel !) waarvan de vraag was in hoeverre de trend toch overeen zou kunnen komen met WA trends. De trend blijkt een beetje overeen te komen, maar lang niet zo duidelijk als trends tussen WA pakketten onderling.

We merken dat de resultaten goed meer duidelijkheid verschaffen voor de accepteerbaarheid van meetverschillen en dat behoefte is naar meer en uitgebreider onderzoek. Dit betekent dat we een vergelijkbaar ‘verschillen in webstatistieken’ project starten waarin meer pakketten worden onderzocht, meer meeteenheden worden meegenomen en extra aandacht kan worden gegeven aan de verschillende definities van de pakketten.

Heb je interesse om hieraan mee te werken? Mail naar martijn.staal [ a t ] tno.nl