Creëer eerlijke markten met behulp van algoritmen

Machine learning kan helpen bij het inrichten van een meer inclusieve samenleving

Fairness en bias in machine learning zijn bloeiende onderzoekslijnen. Het grootste deel van dit werk richt zich op discriminatie en inclusiviteit. Hoewel dit een belangrijke onderzoekslijn is die ik van harte steun, stel ik voor dat technologie bedrijven en platforms ook gaan werken aan ‘bevooroordeelde’ algoritmen die eerlijke markten mogelijk maken. Bias en oneerlijkheid zijn alomtegenwoordig in technologie, ook in machinelearning-technologie. Maar eerlijkheid van markten kan juist ook worden bevorderd door machine learning.

Oneerlijkheid in technologie

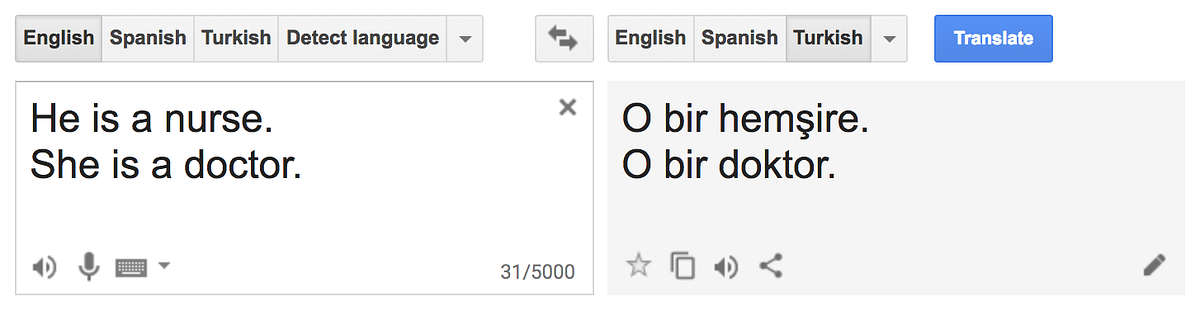

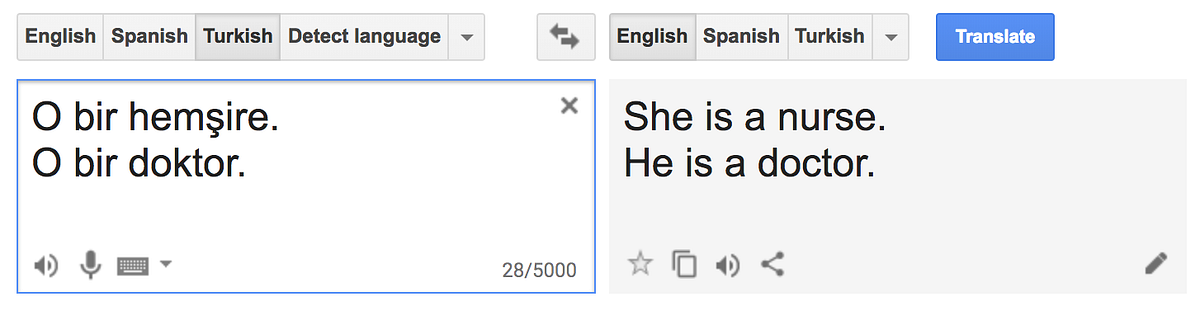

Probeer het maar: typ “He is a nurse. She is a doctor.” in Google Translate en vertaal het naar het Turks. Vertaal vervolgens het resultaat (“O bir bebek hemşire. O bir doktor.”) naar het Engels en je krijgt “She is a nurse. He is a doctor.”

Bron: Aylin Caliskan, Joanna J. Bryson, and Arvind Narayanan. Semantics derived

automatically from language corpora contain human-like biases. Science,

356(6334):183–186, 2017.

Dit is niet alleen een eigenschap van Google Translate, het lijkt verweven in bijna alle technologie, inclusief veel algoritmen. Rachel Thomas geeft in haar recente TEDx-talk een geweldig overzicht van het bewijs van de bias in algoritmen overal om ons heen. Het zit bijvoorbeeld in gezichtsherkenningssoftware (dat werkt nog steeds slecht voor vrouwelijke en Afro-Amerikaanse gezichten), stemherkenning (YouTube genereert automatisch gesloten bijschriften, maar minder nauwkeurig voor een vrouwenstem) en dat is nog maar het topje van de ijsberg.

Rachel Thomas P.h.D. mede-oprichter Fast.ai | TEDxSanFrancisco

De machine learning community is zich bewust van deze vooroordelen en door initiatieven zoals de Fairness, Accountability en Transparency (ACM FAT *) conferentie, Inclusion in Machine Learning en de Algorithmic Justice League, richten we ons op de negatieve effecten van bias.

Technologie kan eerlijke markten stimuleren

Tijdens een bijeenkomst die ik afgelopen april modereerde, over two sided markets en machine learning, ontmoette ik collega Yingqian Zhang. We kwamen te spreken over haar werk over rechtvaardigheid en machine learning in markten. We planden een nieuwe discussie over de eerlijkheid van geautomatiseerde beslissingen in de platformeconomie.

Ik raad ten zeerste aan om de onderzoekspaper van Yingqian (en haar collega’s Qing Chuan Ye en Rommert Dekker) te lezen over de kosten van eerlijkheid en algoritmen (spoiler alert: eerlijkheid kan je meeoptimaliseren voor een zeer kleine prijs). Het is gebaseerd op een bestaande situatie in de haven van Rotterdam waar opdrachten werden geveild om containers te verplaatsen.

De uitdaging die de haven had uitgeschreven was de volgende: vrachtwagens die uit het achterland komen om containers af te zetten of op te halen, zijn vaak inactief. Terminals kunnen profiteren van deze inactieve vrachtwagens door ze opdrachten te geven. Verschillende vrachtwagenbedrijven kunnen bieden op die opdrachten, afhankelijk van hun niet-actieve trucks op specifieke tijden. De terminals beslissen vervolgens over een optimale toewijzing van opdrachten aan bedrijven.

Om te voldoen aan eerlijkheidscriteria bij deze taaktoewijzing, ontwikkelden Yingqian en haar collega’s een zogenaamde ‘polynomial-time optimal method’ bestaande uit twee nieuwe algoritmen: IMaxFlow en FairMinCost. De uitvoer van deze twee algoritmen is een max-min eerlijke taaktoewijzing met de laagste totale kosten.

“Voor wie optimaliseren we eerlijkheid?”

Natuurlijk is deze havenzaak niet uniek, het roept dezelfde vragen op die ook bij mijn vorige werkgever Booking.com veel voorkwamen. Voor wie optimaliseren we eigenlijk eerlijkheid, bijvoorbeeld?

- optimaliseren we eerlijkheid vanuit klantperspectief?

- optimaliseren we eerlijkheid voor vanuit het perspectief van onze leveranciers?

- of optimaliseren we eerlijkheid voor ons eigen platform?

Bij Booking.com hadden we talloze discussies voordat we algoritmen implementeerden die van invloed zouden zijn op beide zijden van onze markt. Bovenstaand onderzoek zou erg welkom zijn geweest als input en structuur in onze discussies. Voor nu is het een goed begin. Hoe je precies een eerlijke markt en een inclusieve samenleving creërt door middel van machine learning, wil ik in een nieuwe blogplost bespreken.

Conclusie

Bias en oneerlijkheid zijn alomtegenwoordig in technologie, ook in machinelearning-technologie. Maar eerlijkheid van markten kan juist worden bevorderd door machine learning. Laat ik duidelijk zijn, dit komt uit recent onderzoek. Er zijn geen duidelijke antwoorden. En zoals altijd moet er meer onderzoek worden gedaan, maar niet alleen door de onderzoeksgemeenschap. Hierbij wil ik de data scientists in de industrie oproepen om deze nieuwe uitdaging aan te gaan naast de bestaande uitdagingen van het toepassen van machine learning op een inclusieve en eerlijke manier.